Low Temperature Sciences

by Meeri Kim

Temperature is one of the few physical properties of matter that we quantitatively measure as part of our daily lives. In the morning, we check the temperature outside to decide what clothes to wear and how many layers to put on. When cooking a meal, we may preheat the oven to a certain temperature or check if the meat is done with a thermometer. Upon feeling sick, we can monitor our body temperature to see if a fever is present.

But what is temperature in a scientific sense? In physics, temperature indicates the direction in which heat energy will spontaneously flow. When two objects are in thermal contact — meaning that heat transfer can occur between them — energy will always flow from the object at a higher temperature to the one at a colder temperature. Absolute zero, the lowest possible theoretical temperature, is the point at which no more thermal energy can be extracted from an object. Quantitatively, absolute zero corresponds to -273,15° C or zero kelvins (K).

In the early 1700s, the concept of a limit to the degree of coldness first came about during experiments by French physicist Guillaume Amontons [1]. When studying the air-thermometer, an instrument that measures temperature by the variation in the volume of a gas, he realised there would be a point at which the volume of air was reduced to nothing. Amazingly, the zero estimated by Amontons’ method (-270° C or 3.15 K) all those centuries ago, wasn’t too far off from the modern value we know today [2].

Today, the low temperatures achieved by humans in the lab hover just a hair above absolute zero, far exceeding anything found in nature. In 2003, a team at the Massachusetts Institute of Technology cooled a sodium gas to half-a-billionth of a degree above absolute zero, the lowest temperature ever recorded [3]. At such temperatures, atoms behave very differently, strange properties of materials begin to emerge, and the effects of interactions at the quantum-mechanical level can be observed. The quest to reach the coldest temperatures ever recorded has led to several Nobel Prize-winning discoveries in superconductivity, superfluidity, and Bose-Einstein condensation.

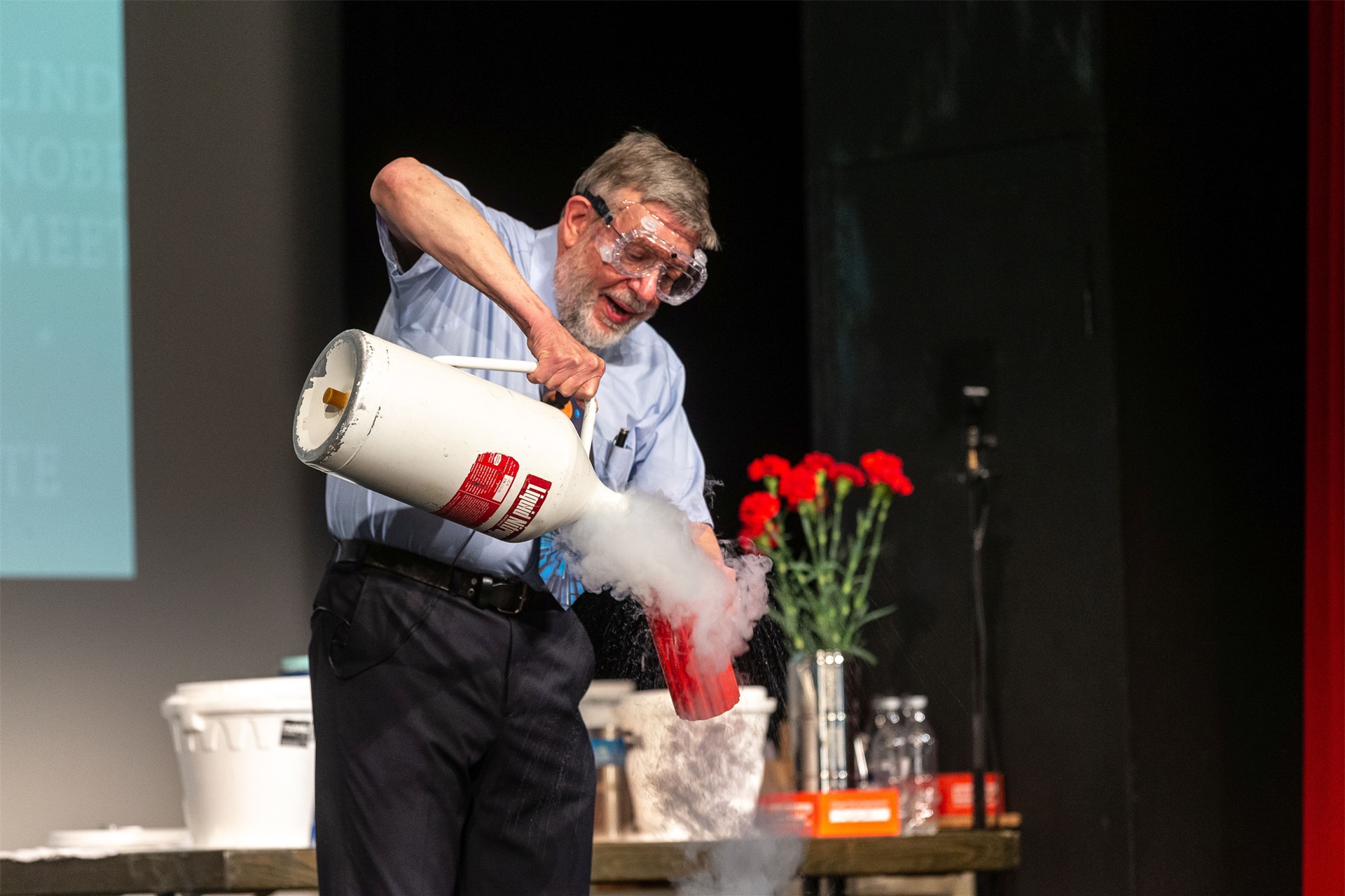

At the closing of his 2019 public talk in Lindau, Nobel Laureate William D. Phillips talked about the scientific odyssey of ever-colder temperatures and the applications of ultracold atoms to society.

(00:57:22 - 01:01:34)

The complete video is available here.

From Gas to Liquid: Early Work in Low Temperatures

At the end of the 18th century, scientists took on the challenge of liquefying the three most common gases: oxygen, hydrogen, and nitrogen [4]. They became known as the “permanent gases” during this time because of their resistance to liquefaction, even after compression with pressures of hundreds of times greater than Earth’s atmospheric pressure at sea level.

In 1869, Irish chemist Thomas Andrews discovered through experiments with carbon dioxide that every gas has a critical temperature above which it cannot be liquified by pressure alone [5]. Dutch physicist Johannes Diderik van der Waals, who received the 1910 Nobel Prize in Physics, later described an equation of state that explained and predicted the critical temperatures of different gases. His Law of Corresponding States, published in 1880, served as a guide during future experiments that led to the liquefaction of hydrogen and helium [6].

Once the concept of critical temperature had been established, the research focus turned to creating lower temperatures instead of higher pressures. One by one, the permanent gases succumbed to liquefaction. Cooling techniques included the cascade process, which uses a series of gases with progressively lower critical temperatures, and the Joule-Thomson cooling effect. The latter is a thermodynamic process that occurs when a gas expands from high pressure to low pressure at constant enthalpy, such as when a compressed gas flows through a small nozzle.

Hydrogen was the last of the permanent gases to liquify, due to its low critical temperature of 33 degrees Kelvin. However, soon scientists realised that helium had an even lower critical temperature, a mere 5 K (-268,15° C). In 1908, Dutch physicist Heike Kamerlingh Onnes first liquified helium with the Joule-Thomson cooling effect, achieving the coldest temperature witnessed on Earth at the time: 0,9 K (-272,25° C) [7]. Afterwards, his experiments with liquid helium led to the 1911 discovery of superconductivity, a property of certain materials where electrical resistance drops to zero at low temperatures [8]. He was awarded the 1913 Nobel Prize in Physics for reaching these major milestones [9].

Douglas D. Osheroff, winner of the 1996 Nobel Prize in Physics, provides a brief overview of Onnes’s major results in the beginning of his 2008 Lindau lecture on scientific advances.

(00:00:46 - 00:06:05)

The complete video is available here.

Getting Closer to Absolute Zero

For almost thirty years, Onnes’s accomplishment held the throne for lowest temperature ever recorded. Then, in 1937, American physical chemist William F. Giauque invented a method called adiabatic demagnetisation that produced even colder temperatures [10]. It can cool a paramagnetic material — one with magnetic dipoles that align parallel to an external magnetic field — down to 1 millikelvin or lower. Adiabatic demagnetisation applies a strong magnetic field to a sample in contact with a cold reservoir. When the cold reservoir is removed and the magnetic field lowered, the temperature of the sample drops.

Giauque received the 1949 Nobel Prize in Chemistry for obtaining a temperature within one-tenth of a degree of absolute zero (−273,15° C) [11]. His experiments also validated the third law of thermodynamics, which states that the entropy in a perfect crystal is zero at the absolute zero of temperature.

Fast forward to the 1980s, when the next major breakthrough in cooling techniques was invented, one that paradoxically used lasers to create “optical molasses.” In 1985, American physicist Steven Chu and his colleagues at Bell Laboratories fired lasers from six directions at a cluster of neutral sodium atoms, which reduced their random motion and thus their temperature. With this method, called Doppler cooling, the researchers achieved an incredibly low temperature of 240 µK [12].

Chu explained the basics of Doppler cooling during his autobiographical 2015 Lindau lecture, titled “A Random Walk in Science,” which highlighted the many projects he worked on before stumbling upon laser cooling and trapping.

(00:09:34 - 00:14:10)

The complete video is available here.

A mere three years later, that record temperature was shattered — somewhat accidentally — by American physicist William D. Phillips, who built upon Chu’s Doppler cooling work. Calculations had pointed to a theoretical temperature limit of Doppler cooling that matched Chu’s experimental value of 240 µK. But Phillips started measuring temperatures as low as 40 µK, six times lower than the supposed limit [13].

Here, in a public lecture at Lindau in 2019, Phillips recalls the happy accident of creating a temperature colder than what scientists thought was theoretically possible with Doppler cooling.

(00:43:49 - 00:49:49)

The complete video is available here.

French physicist Claude Cohen-Tannoudji refined the theory to explain the unexpected results and went a step further with laser cooling. He broke what was called the recoil limit, which originates from the fact that even the slowest atoms are forced to absorb and emit photons. Instead of staying as still as possible, they must take on a small velocity and temperature. Between 1988 and 1995, Cohen-Tannoudji and his colleagues invented a method that converts the slowest atoms to a dark state that does not absorb photons. With six opposing laser beams, they slowed down helium atoms to a corresponding temperature of only 0,18 µK [14].

This flurry of discoveries led to a 1997 Nobel Prize in Physics shared by Chu, Phillips, and Cohen-Tannoudji “for development of methods to cool and trap atoms with laser light." [15] The cooling processes perfected by the three scientists and their colleagues, opened the doors for other innovations, including more accurate atomic clocks and a new state of matter called Bose-Einstein condensate (BEC) — another Nobel Prize-winning discovery, which will be described in detail below.

The following video clip from the 2015 Lindau meeting shows Cohen-Tannoudji talking about some applications of ultracold atoms, including how they are used to improve the accuracy of atomic clocks.

(00:21:14 - 00:26:21)

The complete video is available here.

In his 2019 Lindau lecture, Wolfgang Ketterle gives the audience a window into his experimental setup, where atoms are cooled down to temperatures a billion times lower than that of interstellar space. The German physicist, who won the 2001 Nobel Prize in Physics for creating BEC in the lab, uses laser cooling and other methods developed by Chu, Phillips, and Cohen-Tannoudji.

(00:07:48 - 00:09:41)

The complete video is available here.

The Rise of Superconductivity

One of the most significant results of low temperature sciences is superconductivity, or the phenomenon seen in certain materials to exhibit zero electrical resistance below a certain temperature. After successfully liquefying helium, Onnes sought to use the substance to cool down other materials and record their behavior at low temperatures. At that point, some scientists thought the resistivity of a metal would increase again or even rise to infinity at absolute zero.

In 1911, Onnes and his colleagues tested the resistivity of mercury at 3 K, finding that it was less than 10^-7 of its value at room temperature. In particular, there seemed to be a sharp drop in resistance at 4,2 K [16]. A few years later, this “super-conducting state” was also found in lead and tin, but not gold and platinum.

The underlying mechanism for superconductivity remained a mystery until the 1950s, when theoretical physicists began working on the problem again after World War II. Russian scientists Vitaly Lazarevich Ginzburg and Lev Landau collaborated on a macroscopic theory of type-I superconductors, which cancel all interior magnetic fields when cooled below its critical temperature [17]. Shortly after, another Russian scientist, Alexei Abrikosov, used the Ginzburg-Landau theory of superconductivity to explain the behavior of type-II superconductors. This second group of materials — which are much more practical for technological use — allow both superconductivity and magnetism to exist at the same time.

The 1962 Nobel Prize in Physics was awarded to Landau for a theory on superfluidity [18], another low temperature phenomenon which will be described below, while Abrikosov and Ginzburg shared the 2003 Nobel Prize in Physics for their respective theories on superconductivity [19].

In 1957, three American physicists built on previous theoretical work to develop the first microscopic theory that explained superconductivity. John Bardeen, Leon N. Cooper, and John R. Schrieffer discovered that electrons in a superconductor are grouped into strongly coupled pairs that have a slightly lower energy compared to single electrons [20]. The energy gap above them inhibits collision interactions and leads to zero resistivity below a characteristic temperature.

The so-called BCS (Bardeen, Cooper, Schrieffer) theory successfully explained the strange properties of superconductors and made predictions that were confirmed by later experiments. The three scientists shared the 1972 Nobel Prize in Physics for their efforts [21].

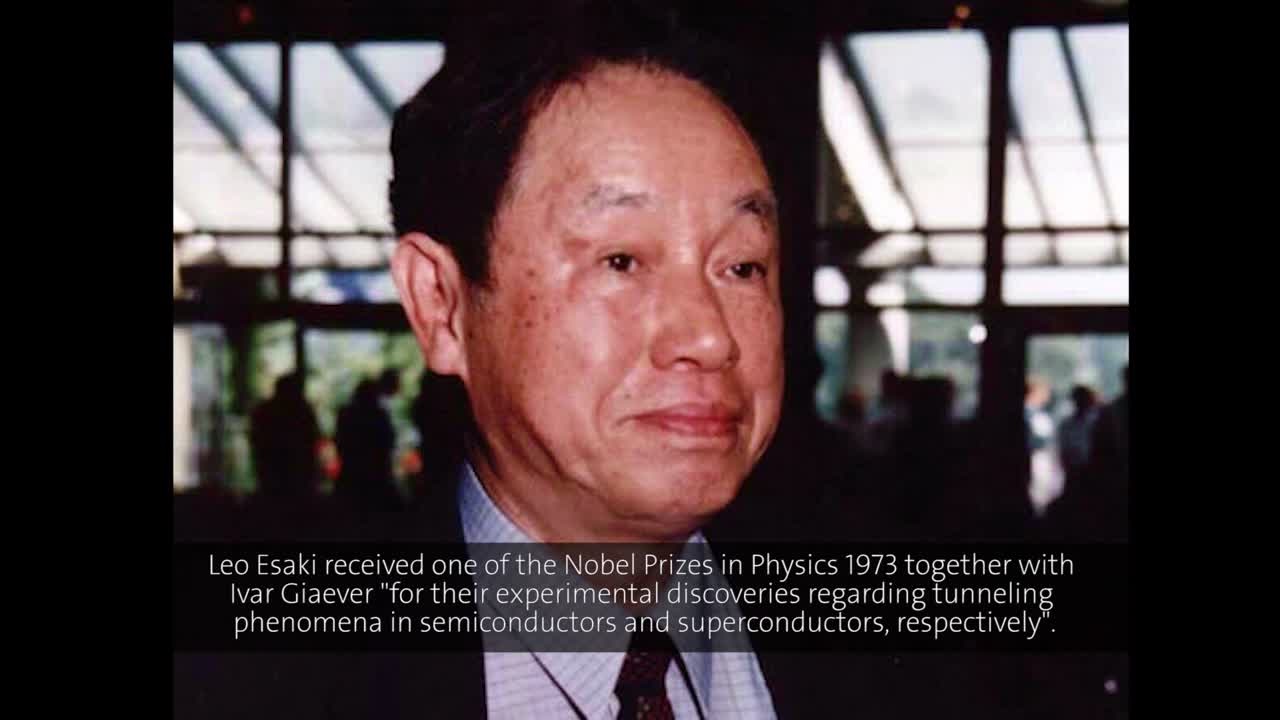

Several more Nobel Prizes followed in the field of superconductivity, including one given the following year to Leo Esaki, Ivar Giaever, and Brian D. Josephson [22]. In the 1950s, Esaki worked on tunneling — a quantum mechanical phenomenon where the wavelike behavior of electrons allows them to pass through classically impenetrable barriers — in semiconductors.

Here is Esaki at the 1997 Lindau Nobel Laureate Meeting speaking about the exciting time in which he completed his Nobel Prize-winning research and the difference between one’s “judicial mind” and “creative mind.”

(00:09:35 - 00:13:22)

The complete video is available here.

Giaever, inspired by Esaki’s research, demonstrated the tunneling effect in 1960 with an experiment that validated the energy gap in superconductors predicted by BCS theory. Over the past several decades, he has been a frequent guest at the Lindau Nobel Laureate Meetings.

In the following clip from the 2008 Lindau meeting, Giaever describes his famous experiment using electron tunneling to measure the energy gap in superconductors.

(00:09:53 - 00:15:45)

The complete video is available here.

Lastly, Josephson took a theoretical approach to Giaever’s findings and predicted new effects in superconductors [23]. As a young graduate student in 1962, he proposed that tunneling between two superconductors would occur across an insulting layer even without applying a voltage. When a constant voltage is applied across the barrier, the current oscillates at a high frequency in the microwave range. Josephson’s results were experimentally confirmed shortly after publication. Today, Josephson junctions — two superconductors coupled by a weak link — form the basis for superconducting quantum computers, superconducting quantum interference devices (SQUIDs), and other devices.

Karl Alex Müller, who received the 1987 Nobel Prize in Physics, gives a quick overview of superconductivity and SQUIDs during his 2004 Lindau lecture.

(00:00:47 - 00:07:43)

The complete video is available here.

The next major leap forward in the field came with the discovery of high-temperature superconductivity more than twenty years later. The dream of electric currents flowing without resistance proved very difficult to implement in practice, since at that point, all superconducting materials had to be cooled down with liquid helium.

In 1986, Swiss physicists J. Georg Bednorz and Karl Alex Müller stunned the scientific world when they uncovered a new class of materials that displayed superconductivity at temperatures far higher than previously observed [24]. After testing several newly developed ceramic materials called oxides, they struck scientific gold with a barium-lanthanum-copper oxide, which had a critical temperature of 35 K (-238° C).

During his 2013 Lindau lecture, Müller outlines the method that he and Bednorz used to combine three different oxides — materials that were considered “dirty” at the time — and the much faster synthesis technique that has replaced it.

(00:07:33 - 00:14:23)

The complete video is available here.

The finding sent a shockwave throughout the field, and laboratories around the world began to investigate oxides on their own. In early 1987, materials were found with critical temperatures greater than 90 K above absolute zero. That same year, only a year after their discovery, Bednorz and Müller were awarded the Nobel Prize in Physics [25].

In his 2019 agora talk, Bednorz traces the winding path he took from a high school student interested in science to a Nobel Laureate. The following clip highlights his biggest breakthrough, the discovery of high-temperature superconductivity.

(00:15:37 - 00:23:52)

The complete video is available here.

Theoretical physicists sought to explain the nature of high-temperature superconductivity, which fell outside the bounds of BCS theory, but a full understanding of these unexpected materials remains elusive even today. And while applications of high-temperature superconductors have been hindered by practical difficulties — materials are very brittle and tend to have impurities that affect performance — researchers are actively working to overcome them [26]. SQUIDs made with high-temperature superconductors can detect magnetic fields 100 billion times smaller than the Earth’s field. In addition, superconducting magnets are used in magnetic resonance imaging (MRI) machines, nuclear magnetic resonance (NMR) spectrometers, mass spectrometers, and particle accelerators.

Fluids with Zero Viscosity

After the liquefaction of helium by Onnes, researchers worldwide began to study its unique properties. Onnes’s successor as director of the physical laboratories in Leiden, Willem Keesom, found a notable discontinuity in the specific heat of liquid helium at 2,186 K [27]. He called this transition the “lambda-point,” due to the shape of the specific heat curve and its similarity to the Greek letter. Liquid helium above the lambda-point was “Helium I,” according to Keesom, while liquid helium below was known as “Helium II.”

A year later in 1937, Soviet physicist Pyotr Leonidovich Kapitsa explored whether a small viscosity could be responsible for Helium II’s large thermal conductivity [28]. He measured its viscosity and was shocked to observe it was at least 1.500 times smaller than that of Helium I at normal pressure. Since the abrupt change of state reminded him of superconductivity, Kapitsa called Helium II a “superfluid” — the first use of such a term. He won the 1978 Nobel Prize in Physics for his discovery [29].

Superfluidity is widely regarded as one of the most dramatic examples of quantum mechanics in the visible world. The most obvious aspect, as Kapitsa noticed, is the ability of liquid helium in the superfluid state to flow without friction. However, other odd aspects include the ability to crawl up the walls of a container and sustain persistent currents in a ring-shaped container.

A 2016 Lindau lecture by Phillips outlines an experimental setup in his lab at the National Institute of Standards and Technology that encompasses the latter scenario.

(00:11:03 - 00:12:53)

The complete video is available here.

But what is the connection to quantum mechanics? The theoretical explanation for superfluidity came shortly after Kapitsa’s experiments in pioneering work by Landau, who also later came up with the Ginzburg-Landau theory of superconductivity. Landau, the house theoretician at the Institute of Physical Problems in Moscow, had been arrested in 1938 for anti-Stalinist discussion with colleagues. Kapitsa, the Institute’s director, had him released from jail by writing to the prime minister, insisting that he needed Landau to work on a theory of the newly discovered phenomenon of superfluidity [30].

In 1941, Landau published his results [31]. He proposed a two-fluid hydrodynamical model that separated a superfluid into two parts: a classical part that follows the usual rules of fluid dynamics and a quantum superfluid component. The percentage of each part in liquid helium varies with temperature, and as the temperature gets close to absolute zero, the quantum portion takes over. Although his work covered all branches of theoretical physics, Landau won the Nobel Prize twenty years later specifically for his explanation of superfluidity.

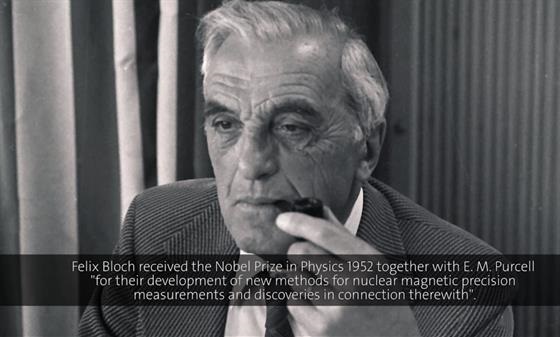

During the 1976 Lindau meeting, Felix Bloch — whose own research was quite far from the topic at hand — spoke about the problem of a superfluid rotating in a ring container.

(00:01:19 - 00:03:38)

The complete video is available here.

Research on superfluidity continued after World War II, and scientists in the U.S. found themselves with large quantities of the light isotope of helium, helium-3, leftover from hydrogen bomb production. They wondered whether helium-3 could also be cooled into a superfluid state. In the early 1970s, American physicists David M. Lee, Douglas D. Osheroff, and Robert C. Richardson succeeded in making superfluid helium-3 at a temperature only about two thousandths of a degree above absolute zero. They won the 1996 Nobel Prize in Physics for their endeavor [32].

During the latter part of his 2008 Lindau lecture, Osheroff recalled his time as a graduate student, working late nights to pursue evidence of superfluidity in helium-3. By “BCS transition,” he refers to the point where the normal state of atoms — instead of electrons, as in superconductors — moving independently gives way to a BCS state where pairs of atoms are bound together.

(00:26:40 - 00:31:20)

The complete video is available here.

A New State of Matter

From the moment Kapitsa first discovered superfluidity, theoreticians began to wonder about the mechanism behind liquid helium’s paradoxical behavior. Landau’s two-fluid hydrodynamical theory, while rewarding in a big-picture sense, did not provide a microscopic view of superfluids.

German physicist Fritz London postulated back in 1938 that the Helium II was undergoing some kind of Bose-Einstein condensation (BEC) at the lambda-point [33]. BEC is a state of matter first predicted by Albert Einstein that occurs in atoms cooled to near absolute zero. At this stage, the individual atoms collapse into a single, shared quantum state at the lowest available energy.

In his Nobel Lab 360°, Ketterle explains the concept of BEC as a new form of matter.

Wolfgang Ketterle – Nobel Lab 360°, clip titled “What is a Bose Einstein Condensate?”

London’s colleague, Laszlo Tisza, took the idea a step further by introducing a two-fluid model where the superfluid component was analogous to BEC. The lack of friction or viscosity in a superfluid originated from the coherent motion of atoms in the same single-particle quantum state. Further work in the period 1957 to 1964 brought together the theories of London, Tisza, and Landau to show that BEC is indeed the microscopic basis for superfluidity in liquid helium.

It would be three more decades before the creation of a BEC for the first time in a lab. In June 1995, a BEC comprised of roughly 2.000 rubidium atoms was produced by American physicists Eric A. Cornell and Carl E. Wieman at the Joint Institute for Laboratory Astrophysics (JILA) [34]. A few months later, Ketterle did the same at the Massachusetts Institute of Technology with even more sodium atoms. These massive achievements represented a culmination of decades of innovative research in the low-temperature sciences.

In his 2008 Lindau lecture, Phillips gives a brief overview of what BEC is, and how to create it in the lab.

(00:02:32 - 00:05:20)

The complete video is available here.

After other groups failed to create BEC with hydrogen atoms, Cornell and Wieman turned to alkali atoms because of the ability to use laser cooling, which couldn’t be easily employed in the case of hydrogen. They first laser-cooled rubidium atoms in a magneto-optical trap, which prevents them from falling down due to gravity. The atoms were then transferred into a purely magnetic trap, and a process called evaporative cooling allowed the most energetic atoms to escape the trap. The ones left behind had an extremely low temperature of 20 nK, and a measurement of the velocity distribution of the atoms confirmed that they had condensed into a unified BEC.

Ketterle and his colleagues chose to work with sodium atoms instead and published their results only four months later [35]. The sodium BEC created by his lab contained many more atoms — by a factor of more than two orders of magnitude — and he also invented a non-destructive imaging method to study the new state of matter [36]. Cornell, Wieman, and Ketterle shared the 2001 Nobel Prize in Physics for their accomplishments [37].

In his 2019 Lindau lecture, Ketterle speaks about how his lab regularly creates a million atoms at nanokelvin temperatures.

(00:09:49 - 00:11:52)

The complete video is available here.

Interestingly, Wieman now devotes his intellectual efforts toward bettering science — and particularly, physics — education. Here he is at the 2016 Lindau Nobel Laureate Meeting during the beginning of his lecture, titled “A Scientific Approach to Learning Physics,” explaining how and why he switched his research focus.

(00:00:52 - 00:02:42)

The complete video is available here.

The Future of the Low-Temperature Sciences

Advances in the fields of low-temperature physics, superconductivity, superfluidity, and BECs continue to occur at a rapid pace. Since 1995, many laboratories worldwide regularly reach nanokelvin temperatures. In fact, Ketterle led the team at MIT who reached 500 pK, the lowest temperature ever recorded. Some of the biggest tech companies in the world creating their own superconducting quantum computers, which use quantum mechanical phenomena to outperform classical computers in certain areas. Superfluids have been recently applied to spectroscopic techniques as a quantum solvent to dissolve other chemicals. BECs have been produced for a number of different isotopes, made up of hundreds of thousands of atoms. Scientists have even created a condensate from pairs of fermionic atoms in the 2000s.

During his 2019 Lindau lecture, Ketterle spoke about the importance of studying ultracold atoms, as well as how the field contributes to materials science and the rest of physics.

(00:05:42 - 00:07:40)

The complete video is available here.

Time will only tell how much closer humankind will get to absolute zero, and what kinds of new physics will reveal itself in the process. But if history is any indication of the future, then the continued exploration of the coldest places in the universe should be surprising, exhilarating, and probably quite strange.

Bibliografy

[1] Wisniak, J. (2004) Guillaume Amontons. Revista CENIC. Ciencias Químicas, vol. 36 (3), pp. 187-195

[2] Encyclopædia Britannica. (2019) “Absolute zero.” https://www.britannica.com/science/absolute-zero

[3] https://news.mit.edu/2003/cooling

[4] Ford, P. J. (1981) “Towards the Absolute Zero: The Early History of Low Temperatures.” South African Journal of Science, vol. 77, pp. 244-248

[5] Andrews, T. (1869) "The Bakerian Lecture: On the Continuity of the Gaseous and Liquid States of Matter", Philosophical Transactions of the Royal Society of London, vol. 159, pp. 575–590

[6] https://www.nobelprize.org/prizes/physics/1910/waals/biographical/

[7] https://www.nobelprize.org/prizes/physics/1913/onnes/biographical/

[8] Dahl, P. F. (1984) “Kamerlingh Onnes and the Discovery of Superconductivity: The Leyden Years, 1911-1914.” Historical Studies in the Physical Sciences, vol. 15 (1), pp. 1-37

[9] https://www.nobelprize.org/prizes/physics/1913/summary/

[10] Giauque, W. F. and MacDougall, D. P. (1935) “The production of temperatures below one degree absolute by adiabatic demagnetization of gadolinium sulfate.” Journal of the American Chemical Society, vol. 57 (7), pp. 1175-1185

[11] https://www.nobelprize.org/prizes/chemistry/1949/summary/

[12] Chu, S., Hollberg, L., Bjorkholm, J. E., Cable, A., and Ashkin, A. (1985) Three-dimensional viscous confinement and cooling of atoms by resonance radiation pressure.“ Physics Review Letters, vol. 55 (1), pp. 48-51

[13] Lett, P. D., Watts, R. N., Westbrooks, C. I., Phillips, W. D., Gould, P. L., and Metcalf, H. J. (1988) “Observation of Atoms Laser Cooled below the Doppler Limit.” Physics Review Letters, vol. 61 (2), pp. 169-172

[14] Lawall, J., Kulin, S., Saubamea, B., Bigelow, N., Leduc, M., and Cohen-Tannoudji, C. (1995) “Three-Dimensional Laser Cooling of Helium Beyond the Single-Photon Recoil Limit.” Physics Review Letters, vol. 75 (23), pp. 4194-4197

[15] https://www.nobelprize.org/prizes/physics/1997/summary/

[16] Goodstein, D. and Goodstein, J. (2000) “Richard Feynman and the History of Superconductivity.” Physics in Perspective, vol. 2, pp. 30-47

[17] Ginzburg, V. L. and Landau, L. D., Zh. (1950) “On the theory of superconductivity.” Eksp. Teor. Fiz., vol. 20, p. 1064

[18] https://www.nobelprize.org/prizes/physics/1962/summary/

[19] https://www.nobelprize.org/prizes/physics/2003/press-release/

[20] Bardeen, J., Cooper, L. N., and Schrieffer, J. R. (1957). "Microscopic Theory of Superconductivity." Physical Review, vol. 106 (1), pp. 162-164

[21] https://www.nobelprize.org/prizes/physics/1972/summary/

[22] https://www.nobelprize.org/prizes/physics/1973/press-release/

[23] Josephson, B.D. (1962). "Possible new effects in superconductive tunnelling". Physics Letters, vol. 1 (7), pp. 251–253

[24] Bednorz, J. G. and Müller, K. A. (1986) “Possible high Tc superconductivity in the Ba-La-Cu-O system.” Zeitschrift fur Physik B Condensed Matter, vol. 64, pp. 189-193

[25] https://www.nobelprize.org/prizes/physics/1987/press-release/

[26] Silver, T. M., Dou, S. X., and Jin, J. X. (2001) “Applications of high temperature superconductors.” Europhysics News, pp. 82-86

[27] Ford, P. J. (1981) “Towards the Absolute Zero: The Early History of Low Temperatures.” South African Journal of Science, vol. 77, pp. 244-248

[28] Kapitza, P. (1938) “Viscosity of Liquid Helium below the λ-Point.” Nature, vol. 141, p. 74

[29] https://www.nobelprize.org/prizes/physics/1978/press-release/

[30] https://www.britannica.com/biography/Lev-Landau

[31] Landau, L. (1941) “Theory of the Superfluidity of Helium II.” Physical Review, vol. 60, p. 356

[32] https://www.nobelprize.org/prizes/physics/1996/summary/

[33] Griffin, A. (2009) “New light on the intriguing history of superfluidity in liquid 4He.” Journal of Physics: Condensed Matter, vol. 21, pp. 1-9

[34] Anderson, M. H., Ensher, J. R., Matthews, M. R., Wieman, C. E., and Cornell, E. A. (1995) Science, vol. 269, p. 198

[35] Davis, K. B., Mewes, M.-O., Andrews, M. R., van Druten, N. J., Durfee, D. S., Kurn, D. M., and Ketterle, W. (1995) Physical Review Letters, vol. 75, p. 3969

[36] https://www.nobelprize.org/uploads/2018/06/advanced-physicsprize2001.pdf

[37] https://www.nobelprize.org/prizes/physics/2001/summary/