Quantum Mechanics

by Anders Bárány

1. Quantum Mechanics and Nobel Prizes 1901-2014

On June 29 year 1900 the Nobel Foundation was born, by its Statutes being accepted by the ”King”, i.e. the Swedish Government. The five Nobel Committees could start their work by sending out invitations to nominate for the first Nobel Prizes. On December 14 the same year, the German theoretical physicist Max Planck gave a talk, at a meeting of the German Physical Society, in which he presented the idea that electromagnetic energy could only be emitted in quantized form. This idea is usually looked upon as the fundament of what later was called Quantum Mechanics, born on December 14 year 1900.

After a long and dramatic series of events, Planck finally received the 1918 Nobel Prize in Physics ”in recognition of the services he rendered to the advancement of Physics by his discovery of energy quanta”. The decision was taken in the autumn of 1919 and Planck was invited to Stockholm to receive his prize on June 1, 1920. By then many interesting developments had taken place in quantum physics, some of which would soon also be recognized with Nobel Prizes.

Planck had used the idea of energy quanta as a way to derive a certain mathematical expression, the so-called Planck radiation formula, which he had invented earlier by fitting experimental data. He did not really believe in the existence of quanta, but a young patent clerk, Albert Einstein, took up the idea and used it 1905 to explain some curious facts found in experiments where electrons are emitted from metal surfaces shined on by electromagnetic radiation of different wavelengths. We all know Einstein mostly from his two theories of relativity, but when he received the 1921 Nobel Prize in Physics it was “for his services to Theoretical Physics, and especially for his discovery of the law of the photoelectric effect”.

The decision about Einstein’s Nobel Prize was taken in 1922 and at the same meeting of the Royal Swedish Academy of Sciences, Niels Bohr was named as the recipient of the 1922 prize “for his services in the investigation of the structure of atoms and of the radiation emanating from them”. Bohr had continued taking quanta seriously and been able to explain many properties of atoms using a planetary model. In this model, the electrons can only move in certain allowed orbits around the nucleus and can jump from one orbit to another emitting or absorbing quanta of electromagnetic radiation.

During the 1920’s, the atomic theory was developed further by a rather large set of theoretical physicists, often in close collaboration with experimentalists. Prince Louis-Victor Pierre Ramond de Broglie introduced an idea that could be used as a kind of explanation of the existence of allowed electron orbits in atoms: The electron was associated with a wave motion and an allowed orbit was an orbit with a whole number of wavelengths. For his work, de Broglie was awarded the 1929 Nobel Prize in Physics “for his discovery of the wave nature of electrons”.

But even before 1929, two young men and one somewhat older had brought the ideas of Bohr and de Broglie into the theory that we today call Quantum Mechanics. One of the young men, Werner Heisenberg, had been fed up with the more and more detailed models of atoms and had decided to construct a theory built only on observable quantities. These quantities typically were wavelengths and intensities of emitted light, studied in the laboratory using spectroscopy. Heisenberg received the 1932 Nobel Prize in Physics “for the creation of quantum mechanics, …”. The decision was taken in the autumn of 1933 and at the same meeting of the RSAS, the other young man, Paul Dirac, and the somewhat older Erwin Schrödinger jointly received the 1933 Nobel Prize in Physics “for the discovery of new productive forms of atomic theory”. Schrödinger had developed the wave idea of de Broglie into a theory named wave mechanics, in which the main theoretical tool is what we call the Schrödinger wave equation. From the solutions of this equation follows the behaviour not only of electrons in atoms, but also of atomic particles colliding with each other. Besides introducing Einstein’s relativity into the theory, Dirac had shown that the theories of Heisenberg and Schrödinger were but two representations of a more general way of formulating quantum mechanics in mathematical terms. The three theoretical physicists travelled together to Stockholm and arrived in the morning of December 9. There is a famous photograph from the Central Station, on which each Nobel Laureate is accompanied by a woman. The older Schrödinger by his wife, but the two younger men by their respective mothers, since they were still both unmarried!

After 1933 followed a series of Nobel Prizes in Physics for laboratory discoveries and developments. But in 1945, Wolfgang Pauli was awarded the Nobel Prize in Physics “for the discovery of the Exclusion Principle, also called the Pauli Principle”. This principle, which forbids two electrons (or other so-called fermions) to have the same set of quantum numbers, had already been in use since many years to explain the spectra from atoms and molecules. Another similar “old” contribution that was rewarded much later was done by Max Born, who had been Heisenberg’s mentor and collaborator, but who only received his prize in 1954 “for his fundamental research in quantum mechanics, especially for his statistical interpretation of the wave-function”. With this Nobel Prize, the main pioneers of Quantum Mechanics had been rewarded. Various extensions and applications have, of course, been made and many of them have duly been rewarded with Nobel Prizes by the RSAS.

2. Lindau lectures on Quantum Mechanics 1951-2014

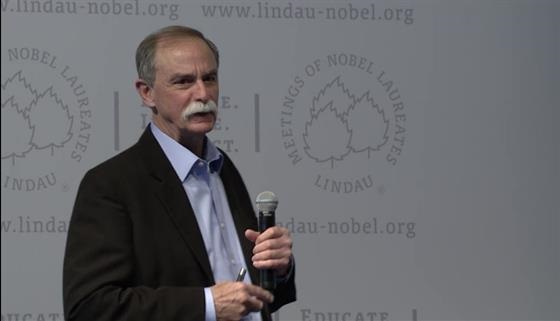

Quantum physics has been the dominating field of activity during the whole 20th Century and continues well into the 21st. That someone who is working in quantum physics is interested in quantum mechanics and might choose it as his lecture topic is understandable. As seen by the Lindau lectures, there is actually a dominance of experimental physicists trying to explain quantum mechanics to the students and young scientists in the audience. But before going back to the audio recordings of the historic lectures, listen to David Gross, who received the 2004 Nobel Prize in Physics together with two other theoreticians “for the discovery of asymptotic freedom in the theory of the strong interaction”. In 2012, Gross gave a lecture entitled “A Century of Quantum Mechanics”. The lecture was inspired by a famous series of conferences in Brussels, named Solvay Conferences after a Belgian industrialist and donator who was contemporary with Alfred Nobel.

(00:06:39 - 00:11:08)

Some of the Lindau lectures are rather technical descriptions of the work of the Nobel Laureate giving it. But not so the 1973 lecture of Nobel Laureate Alfred Kastler, who received his prize in 1966 “for the discovery and development of optical methods for studying Hertzian resonances in atoms”. Instead he chose to give a talk about Max Planck and how Planck arrived at the quantum energy condition. Kastler gives his talk in German and it is entitled “Wie kam Max Planck dazu E = hv zu setzen?”.

(00:04:48 - 00:09:40)

Max Planck himself might have come to Lindau in the beginning of the 1950’s if he had not passed away already in 1947, almost 90 years old. The war had killed his sons and destroyed his home (including the Nobel Diploma), so the one who gave birth to quantum mechanics must have had many sad things to think about at the end. Albert Einstein, who took up Planck’s quantum idea, had disappeared to the US before the war. He was certainly invited to Lindau, but never returned to Europe before he passed away in 1955. But Niels Bohr, who developed the first quantum model of atoms, was around and was invited a couple of times before he finally accepted the invitation and participated in the 1962 meeting with a lecture entitled “Atomic Physics and Human Knowledge”. Bohr was known to speak both English and German with a heavy dialect that was difficult to understand, but his 1962 lecture has been transcribed and the text can be read during the lecture. Sadly enough, Bohr received a stroke after having given the lecture and passed away in the autumn of the same year. So the Lindau lecture became his last public appearance.

(00:06:05 - 00:08:12)

Of the three men who got off the train in Stockholm on December 9, 1933, Schrödinger never accepted the invitations to lecture at the Lindau meetings, even though he lived through the first three physics meetings and didn’t pass away until 1961. But both Heisenberg and Dirac fell in love with the meetings (and in meeting each other) and came back repeatedly. Heisenberg lectured mostly on his new theory of elementary particle reactions, but Dirac had a more varied menu and three of his lectures concern quantum mechanics as such. So far the recording of his first lecture has not been found, which is a pity. It was given at the first physics meeting in 1953 and was entitled “Quantum Mechanics and the Ether”. (Someone who is strongly interested in this lecture can dig out a German translation published in the journal Naturwissenschaftliche Rundschau in 1953, vol. 6, page 441.) Dirac’s second lecture on this theme, “The Foundations of Quantum Mechanics”, was given in 1965 and his third, in 1968, was entitled “How far will Quantum Mechanics go?”. Among the many contributions that Dirac gave, and that were rewarded with a Nobel Prize in 1933, was combining the theories of Heisenberg and Schrödinger with Einstein’s special theory of relativity. Some quite strange phenomena seemed to appear in the combined theory, but were resolved when the anti-electron, the positron, was discovered. It then turned out that the so-called Dirac equation described the behaviour of both electrons and positrons.

(00:00:20 - 00:04:01)

Both Wolfgang Pauli and Max Born participated in Lindau Meetings. While Pauli didn’t give any lecture, Born lectured a couple of times but strangely enough not on quantum mechanics. As the father of the statistical interpretation of the wave function, one would have expected him to talk on some of the epistemological questions connected with this interpretation. Instead some of these aspects were taken up by Leon Cooper, who received the 1972 Nobel Prize in Physics with two others “for their jointly developed theory of superconductivity, usually called the BCS-theory”. When Cooper lectured in 1976, the title was “How Possible becomes Actual in the Quantum Theory”.

(00:33:09 - 00:37:00)

Another theoretical physicist with an interest in similar questions was Eugene Wigner, who received one of the two Nobel Prizes in Physics given in 1963 “for his contributions to the theory of the atomic nucleus and the elementary particles, particularly through the discovery and application of fundamental symmetry principles”. Wigner had become interested in the so-called quantum mechanical measuring process. If one applies quantum theory consistently, without any other hypothesis, the use of a macroscopical apparatus to make a measurement on a microscopical quantum system leads to the so-called problem of collapse of the wave function, which is needed to make the apparatus show a definite result. This problem is addressed in the 2013 lecture of Serge Haroche below. The title of Wigner’s lecture, given in German, is “Die Quantenmechanische Bedeutung des Begriffs Realität”, in translation “The Quantum Mechanical Meaning of the Concept of Reality”.

(00:02:13 - 00:06:36)

In 1955, the experimentalist Willis Lamb received the Nobel Prize in Physics “for his discoveries concerning the fine structure of the hydrogen spectrum”. This discovery started a rapid development, in which, among others, Sin-Itiro Tomonaga, Julian Schwinger and Richard Feynman developed what is called quantum electrodynamics. This theory can be used to describe not only electrons and positrons, but also the photons that are the quantized particles of the electromagnetic field. For this development the three received the 1965 Nobel Prize in Physics. Lamb came many times to the Lindau Meetings and since he understood what many of the students and young scientists in the audience wanted to hear, he gave a set of no less than eight lectures on quantum mechanics 1968-2001. His 1985 lecture is entitled “Schrödinger’s Cat” and it is concerned with a classical thought experiment of a cat that can be both dead and alive at the same time. It is interesting to note that in 2013, the experimental technique had been developed so far that the cat again appears. It does so in David Wineland’s lecture, not as a thought experiment but as a real one (see below)!

(00:18:04 - 00:20:22)

During the second part of the 20th Century, the understanding of quantum mechanics and the experimental techniques in quantum physics had reached the level where one could call the physicists “quantum engineers”. Good examples of such “engineers” can in particular be found working of in the field of semiconductors, starting with the invention of the transistor and the integrated circuit. Leo Esaki received one of the 1973 Nobel Prizes jointly with Ivar Giaever “for their experimental discoveries regarding tunnelling phenomena in semiconductors and superconductors, respectively”. Giaever has repeatedly lectured at the Lindau Meetings, but most of the time on his (interesting) activities in biophysics (cf. the Topic Cluster on Cancer). Esaki has so far given two lectures that are relevant here. In 1997, he lectured on “Quantum Mechanics and Semiconductor Science”.

(00:07:52 - 00:10:35)

In 2012 the Nobel Prize in Physics was given jointly to two excellent “atomic engineers”, Serge Haroche and David Wineland, “for ground-breaking experimental methods that enable measuring and manipulation of individual quantum systems”. As for all Nobel Laureates in Physics, Chemistry and Physiology or Medicine, they were invited to the Lindau Meeting of the year following their Nobel Prize, irrespective of the topic of this meeting. So in 2013, a meeting year for chemistry, both Haroche and Wineland came to Lindau and gave lectures on experiments that most of the founding fathers of quantum mechanics would have thought impossible. Wineland’s lecture is entitled “Superposition, Entanglement and Raising Schrödinger’s Cat”, while Haroche lectured on “Controlling Photons in a Box and Exploring the Quantum to Classical Boundary”. I happened to be present at these lectures and looking out on the audience, I thought I could see Einstein and Schrödinger, who both didn’t believe that this kind of experiments would ever be possible, looking flabbergasted, while Niels Bohr, who took a more pragmatic stand, nodded and sucked on his (unlit) pipe, mumbling “It is hard to make predictions, in particular concerning the future”.

(00:00:50 - 00:06:03)

(00:20:52 - 00:26:36)

Additional Mediatheque Lectures on Quantum Mechanics: