Cosmology

by Anders Bárány

Cosmology is the science of the structure of the Universe. Today cosmology also includes the study of the birth and development of the Universe, which earlier was termed cosmogony. When Albert Einstein worked out the general theory of relativity in the beginning of the 20th Century, he invented a formidable mathematical tool. This tool can be used to create a large set of mathematical models of hypothetical universes. By studying their properties and comparing with various observations, one hopes to reach a better understanding of the particular universe that we call “the Universe”.

However, as is well known, Albert Einstein did not receive his 1921 Nobel Prize for his relativity theories, but mainly “for his discovery of the law of the photoelectric effect”. Hence, one might argue that the first Nobel Prize in the field of cosmology was given to Victor Hess in 1936 “for his discovery of cosmic radiation”. One can also argue about the classification of some other prizes, but it is quite clear that the 1978 Nobel Prize, given to Arno Penzias and Robert Wilson “for their discovery of cosmic microwave background radiation”, belongs to the true cosmology prizes. Interestingly enough, the satellite project COBE, that was started to study the background radiation discovered by Penzias and Wilson, made two discoveries that – yet again – resulted in a Nobel Prize: in 2006, John Mather and George Smoot were honoured “for their discovery of the blackbody form and anisotropy of the cosmic microwave background radiation”.

Just five years later, in 2011, Saul Permutter, Brian Schmidt and Adam Riess received the Nobel Prize “for the discovery of the accelerating expansion of the Universe through observations of distant supernovae”. The three scientists are representatives of two research teams who were using the red shift of the light from distant supernovae to study the expansion of the Universe. The idea was to measure the decrease of the expansion rate with high precision. But both teams discovered that the expansion of the Universe seems to be accelerating rather than deccelerating. Later studies have corroborated this interpretation of the results and today most astrophysicists (and the Royal Swedish Academy of Sciences) agree on the existence of the accelerated expansion of the Universe.

Historic Lindau Lectures (1951-2003) and Cosmology

Cosmology has for long been a science with a dominance of theoretical models and rather few observations. This has attracted some of the sharpest minds and there is no surprise that many of the Nobel Laureates lecturing at the Lindau Meetings have been interested in the history and science of cosmology, even if their own prize motivations were not related to cosmology. Albert Einstein himself lived until 1955, so he could in principle have attended some of the very first Lindau Meetings. But after leaving Europe in 1933, he never came back, so his voice is not present among the many historic lecture recordings.

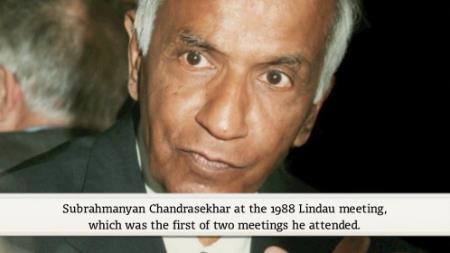

But Einstein’s voice can be heard through the astrophysicist Subrahmanyan Chandrasekhar, who received the Nobel Prize in Physics in 1983 “for his theoretical studies of the physical processes of importance to the structure and evolution of the stars”, since he quotes Einstein in his first lecture at the Lindau Meetings in 1988. Its title was “The Founding of General Relativity and its Excellence” and the lecture first gives a pedagogical account of the way that Albert Einstein initially realized the need to enlarge the special theory of relativity so that it would include gravitational forces, which took him ten years of hard work. In the second part of his lecture, Chandrasekhar discusses why physicists at the time of the lecture believed in the theory of general relativity. He argues that this belief is not based on experimental evidence but rather comes more from the internal consistency of the theory and the fact that it does not contradict other physical theories.

(00:00:12 - 00:06:06)

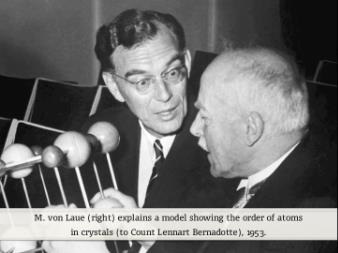

Among the many Nobel Laureates who have lectured at Lindau, the one who received his prize earliest in the 20th Century is Max von Laue. He received the 1914 Nobel Prize in Physics “for his discovery of the diffraction of X-rays by crystals”. But he also worked on the theory of relativity, wrote books about it and was a good personal friend of Einstein’s. In 1956 he gave a lecture (in German) with the title “From Copernikus to Einstein” in Lindau. The main topic of the lecture is Einstein’s general theory of relativity. As a theory of gravitation and cosmology, it had been unjustly expelled to the boundary regions of physics, von Laue felt.

(00:30:20 - 00:36:36)

The radio astronomer Antony Hewish, Nobel Laureate in Physics 1974 “…for his decisive role in the discovery of pulsars”, has lectured several times at the Lindau Meetings. In 1988 he gave his second lecture, “Can we Observe the Origin of the Structure in the Universe?”. It brings together several threads of astronomical observations and theoretical ideas, from the discoveries of radio galaxies and quasars, the microwave background radiation, the clustering of galaxies, the theoretical maps of the sky and the need for dark matter. The main point, though, is to explain how we can understand what we observe and measure using the theory of the expanding Universe.

(00:15:02 - 00:19:32)

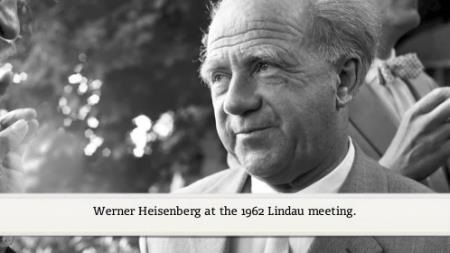

Werner Heisenberg, 1932 Nobel Laureate in Physics mainly “for the creation of quantum mechanics”, also lectured many times at the Lindau Meetings. In 1968 he gave a lecture (in German) with the title “Cosmological Problems in Modern Atomic Physics”. In a general sense, his lecture is still very interesting and quite topical. This can for instance be inferred from the fact that the key argument of Heisenberg is based on the concept of broken symmetry appearing spontaneously in the ground state of certain physical systems and that, 40 years after his lecture, one of the 2008 Nobel Prizes in Physics was awarded to Yoichiro Nambu “for the discovery of the mechanism of spontaneous broken symmetry in subatomic physics”.

(00:00:10 - 00:05:44)

Today there is overwhelming evidence indicating that the Universe is expanding from an extremely dense state, named “the primeval atom” by Georges Lemaître in 1933. Lemaître’s ideas have developed into the standard Big Bang theory, which most astrophysicists adopt today. Hannes Alfvén, the Swedish Nobel Laureate of 1970, received his prize “for fundamental work and discoveries in magnetohydrodynamics with fruitful applications in different parts of plasma physics”. When he gave his lecture “Observations and Cosmology” at the 1979 meeting, he was known to be a strong opponent of the Big Bang theory. So did Alfvén have an alternative theory? Since the 1960’s he had been working on a symmetric model of the Universe originally put forward by Oskar Klein, professor of theoretical physics at Stockholm University. In this model the Universe contains equal amounts of matter and antimatter, so that some stars that we see are made of matter and others of antimatter. Today this theory is more or less obsolete, but still has an historic appeal.

(00:07:47 - 00:11:58)

Recent Lindau Lectures (2004-to date) and Cosmology

During the last decade, the number of talks touching upon cosmology has increased steeply, as has the importance of the field of astro-particle physics. Consequently, almost every talk on particle physics also features some part relevant to cosmology. This development reflects a fundamental change in the scientific nature of cosmology, which is becoming less speculative and more precise. Looking forward, this should set the course for more Physics Nobel Prizes to come.

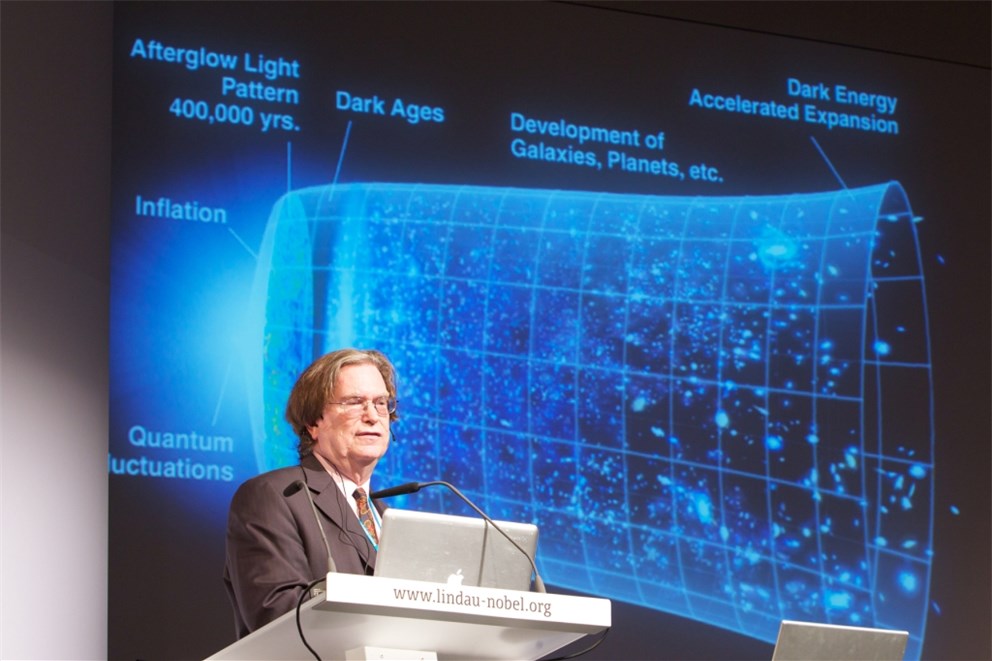

As mentioned above, the 2006 Nobel Prize in Physics was awarded to two of the main investigators of the COBE satellite mission “for their discovery of the blackbody form and anisotropy of the cosmic microwave background radiation”. John Mather, responsible for the instrument that measured the blackbody form of the background radiation, lectured in 2010 about “The History of the Universe, from the Beginning to the Ultimate End”. Among many other things, he tells the amusing story of Einstein’s cosmological constant, the (in)famous gamma, which Einstein put into his equations to explain a static Universe. Today gamma is used to represent dark energy and to motivate the accelerated expansion of the Universe. This is also dicussed by Mather, who, in the spirit of a fortuneteller, even shows a picture of the three 2011 physics Nobel Laureates, Saul Permutter, Brian Schmidt and Adam Riess!

(00:00:40 - 00:05:40)

The other main investigator of the COBE mission, receiving the Nobel Prize in Physics 2006, is George Smoot, who was responsible for the instrument that discovered the anisotropy of the background radiation. In Lindau he lectured in 2008 on “The Beginning and Development of the Universe”. He showed a set of astonishing films from very large computer simulations (performed in Munich and Chicago) of the development of the Universe, taking into account both ordinary and dark matter. In his lecture he also pointed out the 10th anniversary of the discovery of the accelerated expansion of the Universe, which was the motivation to the 2011 Nobel Prize in Physics.

(00:18:10 - 00:26:30)

Nobel Laureate David Gross, who received his prize in 2004 “for the discovery of asymptotic freedom in the theory of the strong interaction”, lectured on “The Future of Physics” in 2005. He presented 20 key questions in modern physics, several of which were related to cosmology. Among them were “What happened before the Big Bang?”, “ What is the nature of dark matter and dark energy?”, “Is general relativity valid where gravity is strong, i.e. in the proximity of black holes?”, “Can we measure the distortion in geometry created by black holes?”, “Can quantum mechanics describe complex systems like our entire universe?” These are some of the questions that young researchers, working in the field of cosmology, will have to tackle in the future. We hope that many of them will eventually be invited to Lindau as Nobel Laureates!

(00:06:07 - 00:10:00)

Additional lectures by the Nobel Laureates associated with Cosmology:

Introductory Mini Lecture on Cosmology.

Paul Dirac 1959: Gravitational Waves.

Antony Hewish 1976: Extreme Physics in the Sky.

Paul Dirac 1979: Does the Gravitational Constant Vary?

Hannes Alfvén 1982: How Space Research Changes Our View of the Universe.

Riccardo Giacconi 2004: X-ray Astronomy.

Masatoshi Koshiba 2004: The Birth of Neutrino Astrophysics.

Frank Wilczek 2005: The Universe is a Strange Place.

Riccardo Giacconi 2008: The Impact of Big Science on Astrophysics.

James Cronin 2010: Cosmic Rays: The Most Energetic Particles in the Universe.

David Gross 2010: Frontiers of Physics.

Gerardus ’t Hooft 2010: The Big Challenges.

George Smoot 2010: Mapping the Universe and its History.

John Mather 2012: Seeing Farther with New Telescopes.

Brian Schmidt 2012: Observations and the Standard Model of Cosmology.

George Smoot 2012: Mapping the Universe in Space and Time.