Carbon

by David Siegel

Carbon – An Essential Ingredient of Life

Every form of life that we know of requires carbon. Our body stores its genome using DNA, a carbon based biopolymer. Our proteins, molecular machines used to gather energy from nutrients, to fight infections or create new biological structures are carbon based. And, last but not least, the food we consume is full of carbon. A kilogram of sugar contains 400 grams carbon, a kilogram of olive oil about 750 grams. We require this carbon to build DNA, proteins and other biomolecules, but it is also our primary source of energy. Our body converts energy-rich, carbon-based molecules like sugars or fatty acids to energy-poor, stable molecules, most of all carbon dioxide. This is done by a strictly controlled biochemical form of combustion, which requires oxygen to proceed.

One of the first experiments that pointed towards this insight was done in 1772 by Joseph Priestley. Priestley put a living mouse and a burning candle under something that resembled a cheese dome. He waited a while – and observed not only that the candle vanished at a certain point, but also that the mouse died in that very instant. The combustion of the carbon in the candle wax consumed all the oxygen in the cheese dome… thus halting the biochemical carbon combustion that the mouse’s body – like any mammalian body – required for survival. However, Priestley could not know this yet and how the mammalian biochemical carbon combustion worked in detail remained unknown until the first half of the 20th century. Only then began a cascade of outstanding scientific achievements, which led to the level of knowledge we have today. Many of its contributors were honoured with a Nobel Prize in Physiology/Medicine or Chemistry.

From Glucose to Carbon Dioxide - Glycolysis and the Citric Acid Cycle

In 1922, Archibald Hill and Otto Meyerhof shared a Nobel Prize in Physiology or Medicine for their discoveries relating to the workings of muscles. Amongst other things, Hill and Meyerhof could show that muscles required oxygen to produce heat. Continuing his work with muscle cells, Meyerhof later played a key role in the elucidation of one of the biochemical mechanisms explaining this observation: glycolysis. Almost all organisms use the glycolysis pathway for the biochemical combustion of carbon originating from sugars. In a multi-step reaction involving a range of enzymes, a glucose molecule (containing six carbon atoms) is “burnt” to yield two pyruvate molecules (containing three carbon atoms each) and energy in the form of ATP. The produced pyruvate is subsequently used in a variety of different metabolic pathways, for instance in the synthesis of fatty acids. Besides Meyerhof, the Nobel Laureates Hans von Euler-Chelpin (Nobel Prize in Chemistry 1929), Otto Warburg (Nobel Prize in Physiology or Medicine 1931), as well as the married couple Carl and Gerty Cori (Nobel Prize in Physiology or Medicine 1947) contributed to the elucidation of glycolysis. Euler-Chelpin and the Coris received their Nobel Prizes for work relating to glycolysis in particular.

Still, although the carbon atoms of glucose are oxidized during glycolysis, the oxidation is not complete. Pyruvate can be broken down further and more energy can be obtained before the biochemical machinery eventually arrives at carbon dioxide as a final waste product. The latter is the most stable form of carbon in the presence of oxygen. It is thus impossible to obtain further energy from it.

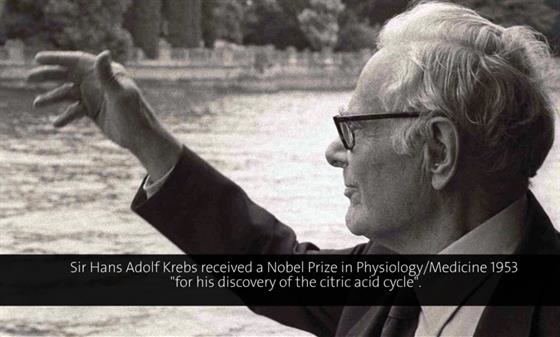

The major biochemical pathway achieving the complete degradation of pyruvate to carbon dioxide is the citric acid or Krebs-cycle. Its namesake, Hans Krebs, received a 1953 Nobel Prize in Physiology or Medicine for his work. It was based on some previous observations of the Hungarian biochemist and 1937 Nobel Laureate in Physiology or Medicine Albert Szent-Györgyi. Szent-Györgyi`s group had confirmed individual reactions of the Krebs cycle working with a model system based on minced pigeon breast muscles.

In the course of the Krebs cycle, energy is gained via the biochemical combustion of the two carbon atoms of an acetate molecule. Acetate is biochemically derived from pyruvate (the end product of glycolysis) by decarboxylation, i.e. the release of one molecule carbon dioxide. It is shuttled into the cycle attached to a coenzyme A molecule. Coenzyme A activates acetate, allowing the subsequent reactions to proceed at a much higher rate. This is of utmost importance, as it ensures an energy supply, which is sufficiently fast to sustain rapid muscular movement, for example. The discoverer of coenzyme A, Fritz Lipmann, shared the 1953 Nobel Prize in Physiology or Medicine with Krebs.

Overall, the Krebs cycle “burns” acetate to two molecules of carbon dioxide - thus completing the biochemical combustion process. As much as two thirds of the carbon combustion in most cells is done via this pathway. The Krebs cycle can hence be considered the major route of biochemical carbon combustion. It further delivers carbon building blocks for many important biomolecules, such as amino acids, which are used to construct proteins, for instance. This implies that not all the carbon entering the cycle is emitted as carbon dioxide, but that organisms extract some of it for constructive biochemical reactions. Carbon indeed has an intriguing twofold function for life on earth: it is both fuel and building stock.

Sir Hans Krebs was a regular attendant of the Lindau Nobel Laureate Meetings. On July the 1st of 1981, only five months before his death, Krebs gave a review on “the evolution of the citric acid cycle and other metabolic pathways” in Lindau. In his talk, he followed up on the question, why the Krebs cycle is a cycle and not a linear pathway. Here is what he had to say:

(00:01:57 - 00:04:49)

A Global Perspective

As illustrated by Joseph Priestley’s cheese dome experiment, carbon is burnt not only biochemically, for example by glycolysis or the citric acid cycle, but also by direct combustion of carbon-based materials like candle wax, wood, natural gas, oil or the fuel derived thereof. Still, regardless of the method of combustion, the end product, carbon dioxide, is the same. Most of it is emitted to the atmosphere. If our earth was identical to Priestley’s cheese dome, the consequences of these emissions would be fatal. Fortunately, the earth has a biosphere. Certain plants therein (the so-called autotrophs) have the ability to convert atmospheric carbon dioxide into biomass. They may do so via a process called the Calvin cycle, discovered by a team around Melvin Calvin, who received the 1961 Nobel Prize in Chemistry for his achievement.

Autotrophic plants may, yet again, be consumed by other organisms and their carbonaceous biomass burnt to carbon dioxide. What ensues is the so-called carbon cycle, which refers to the constant recycling of carbon throughout atmosphere, biosphere, geosphere and hydrosphere.

While atmospheric carbon dioxide is an integral aspect of the carbon cycle and required for life as we know it, there has been increasing concern with regards to a man-made increase in atmospheric carbon dioxide levels, potentially leading to a greenhouse effect and climate change. This issue is as popular as it is controversial. Also at Lindau. At the 2012 Lindau Meeting, two Laureates used their talks to take completely opposite sides on the subject. We will leave it to the reader to draw the appropriate conclusions.

(00:12:45 - 00:16:10)

(00:03:25 - 00:08:34)

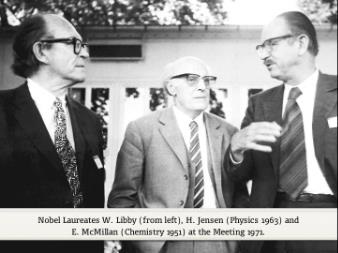

Carbon as a Clock

The fact that carbon is part of all living things and constantly moves through atmosphere and biosphere via the carbon cycle allows for an equally unusual and useful way of measuring time: radiocarbon dating. This technique, which has become invaluable to archaeologists, enables the determination of the age of carbonaceous materials in general, and dead organic matter in particular. Its inventor, Willard Libby, received the 1960 Nobel Prize in Chemistry for his achievement. At the 1971 Lindau meeting, he explained how radiocarbon dating works in detail:

(00:00:22 - 00:03:45)

The Modifications of Elementary Carbon

If you encounter pure carbon in nature, it usually presents itself in one of two modifications: graphite or diamond. In graphite, carbon atoms form three covalent bonds to other carbon atoms, leading to a planar sheet structure. A great number of the resulting sheets are then stacked, whereas individual layers are held together merely by weak non-covalent interactions. This is why you can write with a pencil: the pressure you apply to the tip causes the weakly bound graphite sheets to slide off the stack. For the same reason, graphite is used as a “dry” lubricant. In diamond, on the other hand, each carbon atom forms four, tetrahedrally arranged, covalent bonds to other carbon atoms. This makes diamond the hardest naturally occurring material and explains why it is used in diamond cutters and polishers, for example. Until 1985, it was thought that this is where the story of carbon modifications ends. Three decades and two Nobel Prizes later, we know better.

A Carbon-Based Soccer Ball

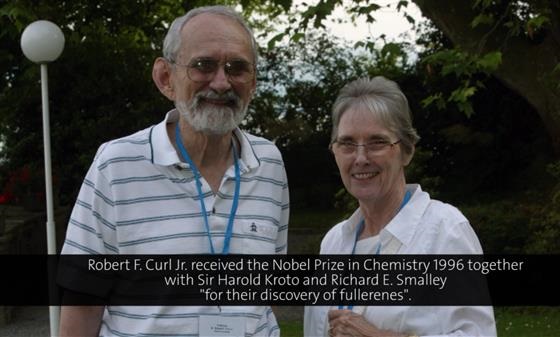

In 1985, Harold Kroto, Robert Curl and Richard Smalley submitted a letter to the journal Nature, in which they reported the detection of a molecule made exclusively from 60 carbon atoms. The team synthesized this molecule by irradiating a rotating graphite disc with a laser. Its structure was suggested to be the one of a ball composed of pentagons and hexagons - or, in plain terms, a football. In reference to the similarly shaped buildings of the American architect Buckminster Fuller, the researchers called the new C60 molecule the Buckminster fullerene. Eleven years later, Kroto, Curl and Smalley received the 1996 Nobel Prize in Chemistry for this discovery. At the 1998 Lindau Meeting, Robert Curl explained how the team came up with the football structure:

(00:07:22 - 00:15:50)

The fullerenes were so exciting to the scientific community (and the Royal Swedish Academy of Sciences) because they represented a new modification of carbon, which is distinctly different to the well-known graphite and diamond modifications. Due to the fundamental importance of carbon in almost all processes of life as well as in materials science, it could be expected that the advent of the fullerenes would entail a horn of plenty of potential technical applications. This excitement was stimulated further, when traces of fullerenes were detected in space. However, as far as we know today, the enthusiasm was probably excessive. More than 25 years after the discovery of fullerenes, there are still no major technical applications.

Graphene

Fortunately, there are already a couple of new stars at the horizon. The fullerenes indeed stimulated the interest of the scientific community in carbon-based materials. This interest inter alia led to the synthesis of carbon nanotubes, which are used in turbines, sports gear and scientific instruments due to their supreme mechanical and electronic properties. It further revived interest in an endeavour, which had, more or less unsuccessfully, been attempted since the 1840s [1]: the isolation and characterisation of a single, pristine carbon layer from graphite. Unfortunately, such pristine, isolated layers, which are referred to as graphene, are not easily obtained: they tend to be “sticky” and highly susceptible to the incorporation of structural defects and impurities.

It was thus only in 2004, when Andre Geim and co-workers at the University of Manchester presented a new, surprising solution to these problems: micromechanical exfoliation. What sounds like a complex technical endeavour is actually ingeniously simple: all you need is a graphite stick and some scotch tape. If the former is pressed against the latter and then removed, tiny graphene flakes remain stuck to the tape. The advantages of this method are its simplicity and the high quality of the obtained graphene flakes, which allows for studies looking at the fundamental properties of the material. Geim and co-workers did just that and came up with a range of amazing results, which eventually led to the award of the 2010 Nobel Prize in Physics.

Today we know that graphene is not only the thinnest material in the universe, it is also the strongest ever characterized [2]: a single graphene sheet, with a thickness of only about 0.0000003 millimetres, would have the ability to support the weight of a kitten, if made large enough. The favourable electronic properties of graphene furthermore render it a promising candidate for high-tech applications (such as high-speed and radio frequency logic devices, thermally and electrically conductive reinforced composites, sensors, and transparent electrodes for displays and solar cells [3]).

Using Carbon Atoms as Lego Bricks: Organic Synthesis of Carbon Compounds

Diamond, graphite, graphene and the fullerenes contain only carbon atoms. In this respect, they could be considered “basic” materials. However, carbon may form bonds with dozens of other elements, such as hydrogen, nitrogen, oxygen, sulphur, boron, the halogens (bromine, chlorine and fluorine) or even metals like lithium, magnesium, titanium and rhodium. This extraordinary chemical versatility allows for tens of millions of carbon compounds. No other element, except hydrogen, is found in that many different molecules. The vast world of carbon compounds ranges from biomolecules such as sugars, fatty-acids, vitamins, proteins and DNA to man-made bioactive molecules such as drugs or pesticides, to technical materials like plastics, resins and paints, petrochemicals or explosives.

Many Nobel Prizes in Chemistry were motivated by discoveries relating to new ways of making such compounds and materials. While some prizes were awarded with respect to a particular technical procedure, like the 1963 chemistry prize to Karl Ziegler and Giulio Natta for their method of making polyolefins, quite a few honour synthetic methods which are not linked to a particular application, but are general enough to push the whole field of organic synthesis forward.

Whether technical or fundamental, many modern synthetic methods awarded with a Nobel Prize have one thing in common: they use metals or metalloids like boron to make previously impossible or inefficient reactions feasible. An excellent example is the Ziegler-Natta method just mentioned. In the 1950s, Karl Ziegler discovered that a combination of aluminium and titanium compounds could sustain the polymerisation of ethylene to polyethylene. Giulio Natta used similar compounds to produce polypropylene. Today, both polyethylene and polypropylene are two of the most common and widely employed plastics. Their total global annual production is well in excess of 100 million tonnes, generating an annual market of around 200 billion EUR. In fact, it is highly unlikely that you do not have a Ziegler-Natta based plastic in your reach while you are reading this. Water bottles, plastic bags, stationery, but also car parts and laboratory equipment are just a few examples. In 1964, Karl Ziegler lectured in Lindau on the history of the discovery of the Ziegler-Natta catalyst (which he paraphrased as “the Muelheim invention”):

(00:47:46 - 00:50:32)

While the “Muelheim invention” established transition metal catalysis of carbon-carbon bond formation on the industrial scale, the idea of using metals to enhance the reactivity of carbon compounds was not new. In 1912, the two Frenchmen Victor Grignard and Paul Sabatier received the 12th Nobel Prize in Chemistry. This 12th Nobel Prize in Chemistry was the first one awarded for organometallic chemistry,that is chemistry involving carbon-metal bonds. Sabatier had shown that the transition metal nickel could be used to catalyse the addition of hydrogen gas to carbon compounds. Grignard had developed a new kind of reagent, which is based on carbon compounds attached to magnesium halides. This famous “Grignard reagent” allows for a facile, controlled formation of single carbon-carbon bonds. It has been both a workhorse and a source of inspiration to organic chemists for more than a century. The field of organometallic chemistry grew considerably in the years to come and several Nobel Prizes ensued, which can all be considered offspring of Grignard’s work. These include the Prize to Ziegler and Natta, the 1973 Prize to Ernst Otto Fischer and Geoffrey Wilkinson, the 1979 Prize to Herbert Brown and Georg Wittig as well as the recent 2010 Prize to Richard Heck, Ei-ichi Negishi and Akira Suzuki.

At the 2011 Lindau Meeting, almost 100 years after Grignard’s award, Ei-ichi Negishi talked about why metals continue to be the major bearers of hope in the ongoing quest for novel green synthetic methods:

(00:03:22 - 00:08:12)

Conclusion

Carbon is the chemically most versatile element. It is essential to all life, both as an energy source and a building stock. It is part of food, fuels and plastics and millions of bioactive compounds. Carbon-related subjects engage researchers from all scientific fields, including the Nobel Prize disciplines Physics, Chemistry and Physiology or Medicine. Indeed, taking an extreme stance, one could argue that there is not a single Nobel Prize unrelated to carbon. In view of this great diversity, it is clearly impossible to discuss all relevant aspects of “carbon” in a single article. In this topic cluster, we have rather pointed out some of the most prominent properties and roles of carbon, relevant to modern society and life on earth. This includes energy metabolism, climate change, radiocarbon dating, the properties of elementary carbon and a brief glimpse on the syntheses of carbon compounds.

Footnotes:

[1] D. R. Dreyer et al., Angewandte Chemie International Edition 2010, volume 49, page 9336.

[2] A. K. Geim, Science, 2009, 324, 1530-1534.

[3] M. J. Allen, V. C. Tung and R. B. Kaner, Chem. Rev., 2009, 110, 132-145.

Additional Lectures by the Nobel Laureates associated with Carbon:

Introductory Mini Lecture on Carbon.

Otto Hahn 1955:Recent Methods for Measuring Geologic and Biologic Age (German presentation).

Karl Ziegler 1964: From Triphenylmethyl to Polyethylene - Less-Well-Known Facts Leading to the Invention Made in Muelheim (German presentation).

Albert von Szent-Györgyi 1969: Molecules, Electrons and Biology (German presentation).

Willard Libby 1971: Radiocarbon Dating and Calibration with Tree Rings and Lake Sediments.

Geoffrey Wilkinson 1974: Transition Metal to Carbon Bonds - Stable and Labile.

Ernst Fischer 1974. Transition Metal-Carbonyl-Carbine-Complexes (German presentation).

Herbert Brown 1980: Organoboranes - The Modern Miracle.

Hans Krebs 1981: The Evolution of the Citric Acid Cycle and Other Metabolic Pathways (German presentation).

Harold Kroto 1998: C60-Buckminsterfullerene: Not Just a Pretty Molecule.

Robert Curl 1998: The Dawn of the Fullerenes: A Research Adventure.

Herbert Brown 1998: A General Asymmetric Synthesis Based on Chiral Organoborane.

Ryoji Noyori 2009: Chemistry: The Key to Our Future.

Richard Schrock 2009: Recent Advances in Olefin Metathesis Catalyzed by Molybdenum and Tungsten Alkylidene Complexes.

Ryoji Noyori 2010: Molecular Catalysis for Green Chemistry.

Ei-ichi Negishi 2011: Magical Power of d-Block Transition Metals: Past, Present and Future.