The Quest to Explain Everything

by Ben Skuse

Knowingly or not, physicists have been attempting to build a ‘theory of everything’ for well over a century. We now assume that this theory would link the four fundamental forces that govern the observable universe – electromagnetism, the strong force, the weak force and gravity – allowing humankind to finally unpick the fundamental workings of all known phenomena. Moreover, it would likely answer enduring mysteries, such as the nature of dark matter and dark energy, why time flows in only one direction and, maybe, how the Universe began. To quote the late, great Stephen Hawking: “If we do discover a theory of everything ... it would be the ultimate triumph of human reason—for then we would truly know the mind of God” [1].Today, physicists’ best explanation for everything is the Standard Model of particle physics. It describes 17 fundamental particles and explains three of the four known forces of nature, and how these forces interact with matter. It is extremely accurate and precise, and neat and simple. But it is not, by any stretch of the imagination, complete.

Electricity and Magnetism: Two Words, One Force

To understand why and how physicists are attempting to build a theory of everything beyond the Standard Model, it is useful to look back at the rich history of combining forces and concepts in physics. The starting point for unifying all the forces of nature was arguably Hans Christian Ørsted’s discovery that a magnetic compass needle could be deflected by an electric current in 1820. Fascinated, over the ensuing decades Michael Faraday explored and experimentally cemented the link between electricity, magnetism and light in terms of fields; even attempting, but ultimately failing, to discover a connection to gravity.

Heavily influenced by Faraday’s insights, in 1865 James Clerk Maxwell published his seminal paper: ‘A Dynamical Theory of the Electromagnetic Field’[2]. The paper described the deep connection between electricity and magnetism mathematically, showing that the two forces are essentially two sides of the same coin. Later simplified by Oliver Heaviside to just four equations from 20, Maxwell’s interpretation of this connection became known as Maxwell’s equations of electromagnetism.

Maxwell derived two revolutionary conclusions from his eponymous equations. The first was that light was nothing more than electromagnetic waves. The second, to paraphrase Albert Einstein (Nobel Prize in Physics 1921), was that physical reality should be thought of as represented by continuous fields and not capable of any mechanical interpretation[3]. Though Maxwell himself left the possibility of a physical aether acting as a medium for electromagnetic waves open, Einstein’s special relativity, first proposed in 1905, showed this not to be the case: no aether was necessary. That fields represent reality – that energy and particles literally reside in non-material fields existing everywhere in space – became the conceptual basis for one of the most important tools in the search for a theory of everything: field theory.

(00:12:08 - 00:17:54)

Gravity: Bending Spacetime

Building on his special theory of relativity – which assumed the laws of physics to have the same form and the speed to light to be constant is constant in all systems, leading to a universe where space and the passage of time are not absolute anymore – Einstein wielded field theory to build his general theory of relativity. Where Maxwell’s equations used charges and currents to determine electromagnetic fields, Einstein’s field equations used mass–energy and linear momentum to determine the geometry of space and time (or spacetime) itself.

From this, Einstein uncovered that spacetime is connected to matter: it tells matter how to move and matter tells spacetime how to curve. Gravity, then, is just the curvature of spacetime. More massive objects bend spacetime more, and so have a stronger gravitational pull.

Many distinguished Lindau visitors have lectured on Einstein’s relativity. For example, Subrahmanyan Chandrasekhar (Nobel Prize in Physics 1930) gave his 1988 Lindau lecture on “The Founding of General Relativity and its Excellence”.

The complete video is available here.

And more recently, David Gross (Nobel Prize in Physics 2004) gave a more traditional but no less informative lecture at the 66th Lindau Nobel Laureate Meeting, explaining why, over 100 years after general relativity was first proposed, Einstein’s insights continue to impact the physics community.

(00:03:22 - 00:07:09)

The complete video is available here.

General relativity has stood the test of time beautifully, accounting for every phenomenon in which gravity dominates, from planetary orbits to the dynamics of the expanding universe as a whole. The most recent and dramatic of its successes was the discovery of gravitational waves. Nearly 100 years after Einstein’s equations predicted these waves, they were directly detected for the first time on 14 September 2015 by LIGO – the Laser Interferometer Gravitational-Wave Observatory. The waves had come from roughly 1.3 billion light-years away where two black holes (another prediction of relativity) span round each other before violently merging together, sending a shudder through the universe.

In his 2016 Lindau lecture, George Smoot (Nobel Prize in Physics 2006) described how the 2015 detection by the LIGO collaboration of gravitational waves from a merging binary pair of 30-solar mass black holes was the culmination of almost a century of efforts.

(00:02:59 - 00:04:24)

The complete video is available here.

And in 2019, Rainer Weiss – who won the 2017 Nobel Prize in Physics alongside Kip Thorne and Barry Barish “for decisive contributions to the LIGO detector and the observation of gravitational waves”[4] – provided Lindau attendees with a first-hand account of the momentous discovery, as well as subsequent gravitational wave discoveries.

(00:11:46 - 00:14:55)

The complete video is available here.

Weak Force: Powering Stars and Creating Elements

From our everyday experience, electromagnetism and gravity are the only forces we can feel. But investigating the nature of matter at smaller and smaller scales slowly led scientists to the realisation that two additional forces were necessary for a complete understanding of the world around us – the strong and weak nuclear force.

The need for the weak force can be traced back to radioactive decay experiments in the late 19th and early 20th centuries. Ernest Rutherford (Nobel Prize in Chemistry 1908) classified rays emitted by radioactive substances according to their ability to penetrate matter, naming them α (now known to be equivalent to helium nuclei), β (emitting electrons) and γ (highly energetic electromagnetic waves) rays. The energy spectra of α and γ rays were discrete, meaning the rays could only have certain fixed energies. This would soon be explained by physicists’ burgeoning understanding of quantum mechanics. But β-rays were an oddity – experiments by James Chadwick (Nobel Prize in Physics 1935) in 1914 showed that β-rays have a continuous energy spectrum[5].

It took 20 years for a theory to be devised that started to explain the β-ray anomaly. Enrico Fermi (Nobel Prize in Physics 1938) defined a new type of force – later called the weak interaction – that was responsible for β decay, transforming a neutron into a proton, expelling an electron (the β particle) and (anti-)neutrino in the process. His theory also showed that a proton can transform into a neutron by emitting a positron and a neutrino. Fermi had explained the continuous energy spectrum of β-rays by using the then hypothetical neutrino to conserve momentum and energy in the process, and exposed the weak interaction’s crucial role in powering stars and creating elements. But his theory did not illuminate the nature of the interaction. It would take decades to unpick the details of the weak force.

(00:30:59 - 00:32:29)

The complete video is available here.

Strong Force: Matter’s Glue

Chadwick, who had identified the continuous energy spectrum of β-rays that would lead to the concept of the weak force, also played a crucial early role in the history of the strong force. His discovery of the neutron in 1932 signalled the beginning of our modern understanding of the nucleus, where nuclei consist of protons and neutrons. But physics understanding at that time suggested nuclei would fly apart due to the repulsive electromagnetic force between positively charged protons. To hold them together, a force was needed that was strong enough to counteract electromagnetic repulsion but also extremely short range.

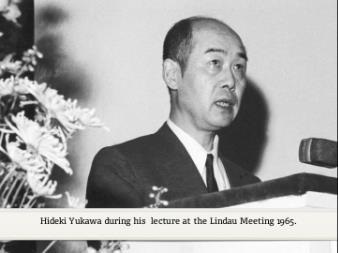

In 1935, field theory was once again wielded – this time by Hideki Yukawa (Nobel Prize in Physics 1949) – to suggest that a strong force is transmitted by the exchange of particles Yukawa called mesons[6]. This way, the strong nuclear force is transmitted between a proton and neutron by the creation and exchange of mesons. And the force remains short range due to the fact that the meson can only exist for a short time because of Heisenberg’s uncertainty principle. In 1949, Yukawa received the Nobel Prize in Physics “for his prediction of the existence of mesons on the basis of theoretical work on nuclear forces”.

(00:04:01 - 00:07:34)

The complete video is available here.

It was later found that the strong force not only stops nuclei from flying apart but, at a much smaller scale, is also responsible for binding fundamental particles called quarks together to make protons and neutrons through the exchange of massless particles called “gluons”. So the strong force is not mediated via mesons

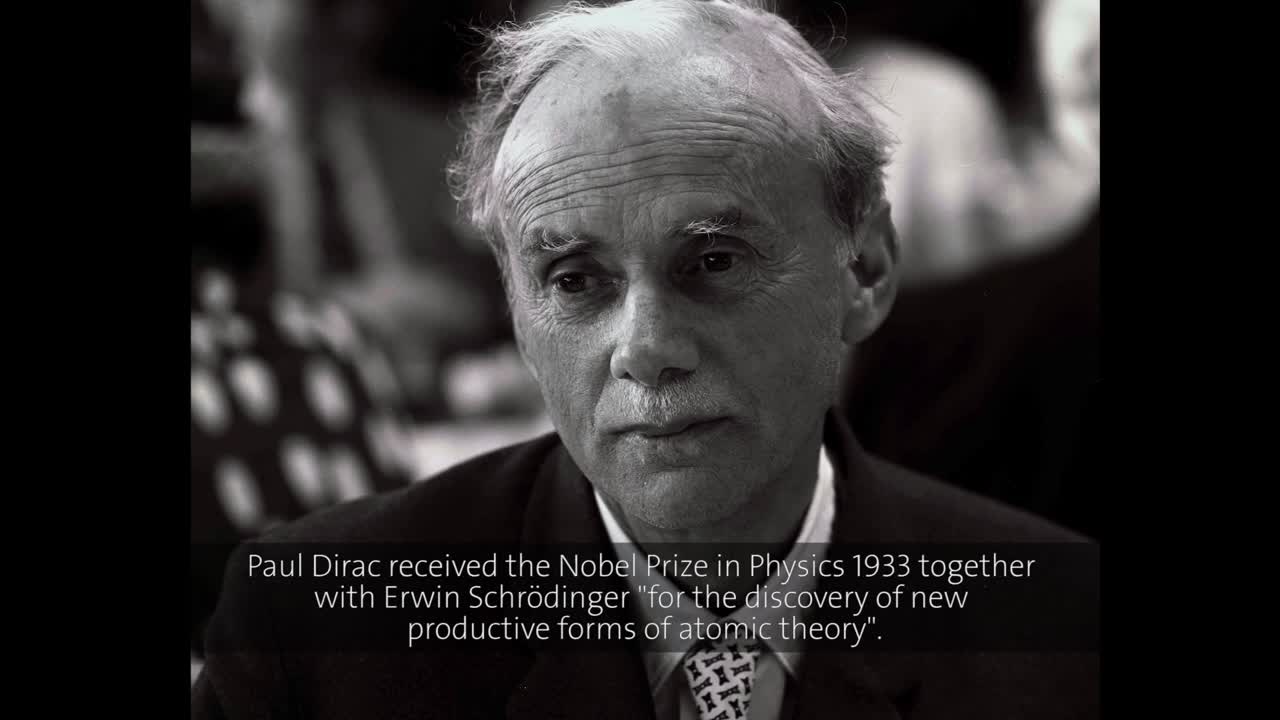

The Importance of Quantum Field Theory

A deeper understanding of electromagnetism, and the weak and strong nuclear forces was to come from the parallel development of quantum mechanics over the course of the 20th century. A glaring problem quantum pioneers faced early on was that the paradigm was not capable of accounting for photons, the basic unit of light and a prime case of relativistic particles. What was needed was a quantum mechanical formalism that contained an explicit description of photons. Paul Dirac (Nobel Prize in Physics 1933) provided it in his seminal 1927 paper ‘The quantum theory of the emission and absorption of radiation’[7]. There, Dirac treated photons as excited states, or quanta, of their underlying electromagnetic fields, naming his procedure quantum electrodynamics (QED).

QED was the first application of quantum field theory (QFT), a theoretical framework that combines classical field theory, quantum mechanics and special relativity – but, importantly, not general relativity, which describes gravity. Despite general relativity’s omission, further development of QED in subsequent decades culminated in a full description of how light and matter interact. The likes of Sin-Itiro Tomonaga, Julian Schwinger and Richard Feynman – who received the 1965 Nobel Prize in Physics for their work on the topic[8] – elaborated on QED, providing tools to calculate concrete processes, and extraordinary agreement with experimental results was found.

(00:13:18 - 00:16:25)

The complete video is available here.

Spurred on by the success of QED, physicists applied QFT methods to the other known forces of nature in the 1960s and 70s. And through these efforts, they were successful in achieving a quantum mechanical understanding of the weak and strong forces. The quantum field theories for the weak and strong forces are named quantum electroweak theory and quantum chromodynamics (QCD), respectively.

Quantum electroweak theory was developed by 1979 Nobel Prize for Physics winners Sheldon Glashow, Abdus Salam and Steven Weinberg, among others. Their theory revealed that the weak and electromagnetic forces – two apparently dissimilar interactions – were actually two different aspects of the same force, a property that only becomes apparent when they become indistinguishable at extreme energies[9]. These insights were extended by 1999 Nobel Prize in Physics winners Gerardus 't Hooft and Martinus Veltman, who elucidated the quantum structure of electroweak interactions to allow physicists to wield electroweak theory and make empirical predictions[10]. Veltman’s 2019 Lindau talk provides a detailed background to his and t’Hooft’s groundbreaking work.

(00:16:05 - 00:27:00)

The complete video is available here.

Like electroweak theory, QCD had a tortuous birth, requiring collective efforts from a range of physicists. Its formulation began when in 1964 Murray Gell-Mann (Nobel Prize in Physics 1969) and George Zweig independently used a scheme dubbed the ‘eight-fold way’ to propose the existence of a new type of particle that makes up bigger particles such as neutrons and protons[11]. Naming them ‘quarks’, their existence was confirmed at the Stanford Linear Accelerator Center (SLAC) in the US just four years later.

The discovery of quarks meant that the strong attraction between protons and neutrons that Yukawa had modelled in 1935 was just a side-effect of a more fundamental force that bound quarks together into protons and neutrons. But what was this force? The introduction of the property of quark ‘colour’ (a type of charge) was a huge step towards an answer. Heinrich Leutwyler, Harald Fritzsch and Gell-Mann suggested colour as the source of a ‘strong field’ in quarks in 1973. The same year, 2004 Nobel Prize winners Frank Wilczek and David Gross, and David Politzer independently, discovered an important property of certain particle interactions called ‘asymptotic freedom’, which meant that the closer quarks are to each other, the less the strong interaction (or colour charge) between them[12]. This property allowed the researchers to develop the theory of QCD.

(00:04:09 - 00:07:51)

The complete video is available here.

The Standard Model and Beyond

By the 1970s, particle physicists were replete with quantum field theories for the strong, weak and electromagnetic forces, meaning they could reduce all of the known particles down to just a few elementary ones, and place them into lists and groups, much like the periodic table of elements. By the mid-1970s, this classification scheme was so well-established it became known as the Standard Model. Yet, at the time, over half of its 17 constituent particles had not even been discovered

Between 1975 and 2012, all of the missing particles were found. The most elusive and final of these was the Higgs boson. The Higgs boson is a particle that mediates the interaction of all matter with the Higgs field, which in turn gives all particles mass. Its discovery on 4 July 2012 at the Large Hadron Collider was the crowning achievement of the Standard Model, recognised by Nobel Prizes awarded for two of the six scientists who first proposed the Higgs boson in 1964.

(00:25:57 - 00:27:53)

The complete video is available here.

Despite its success, the completion and experimental verification of the Standard Model does not mark the end of particle physics. With the theoretical prediction and experimental verification that, at high energy, the electromagnetic interaction and weak interaction unify into a single electroweak interaction, many physicists believe that a more complete model will show that at even higher energy, the strong interaction and the electroweak interaction unify into a single electronuclear interaction.

Theories beyond the Standard Model that predict such a unification of three of the four fundamental forces are called Grand Unified Theories (GUTs). Many attempts at GUT models invoke the concept of supersymmetry, which uses quantum variables to describe space and time, and suggests that every known particle has a yet-undiscovered superpartner particle.

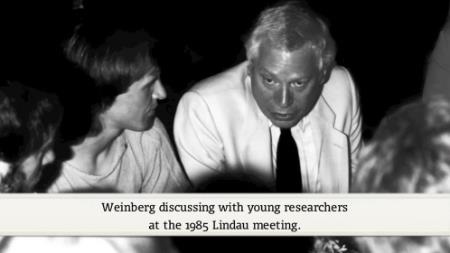

Steven Weinberg’s Lindau talk in 1982 is a time capsule back to soon after the Standard Model was finalised. Already, Weinberg expresses his and his contemporaries’ frustrations at progress to extend our understanding beyond the Standard Model, stating how it seems clear that there is an energy scale at which the electroweak and strong forces unify but no convincing explanation as to how. He goes on to point out that supersymmetry, an idea “invented out of the richness of the imagination” involving a whole new family of undiscovered particles, might offer a route to a GUT; an opinion that is still popular now, as exemplified during a 2016 Lindau panel discussion on “Glimpses beyond the Standard Model”.

(00:23:16 - 00:37:26)

(00:24:20 - 00:32:28)

The complete video is available here.

Towards a Theory of Everything

Though an intense source of frustration, the inability to unify the strong force with electromagnetism and the weak force is not the most glaring problem in the Standard Model. What puzzles physicists most is the absence of gravity. In essence, physicists are dealing with the same problem Einstein grappled with and ultimately failed to solve in his lifetime – how to unify the twin pillars of general relativity and quantum mechanics.

Unlike the electromagnetic force and the strong and weak nuclear forces, gravity – as governed by Einstein’s general theory of relativity – seems incompatible with QFT. When the equations of both are commingled to attempt to answer sensible questions, they generate nonsensical outputs. At its core, the problem lies in the conflict between the continuous, smooth nature of general relativity’s spacetime and the discrete and violently fluctuating nature of the quantum world[13].

Current efforts to reconcile general relativity with QFT come primarily in two flavours: loop quantum gravity (LQG) and string/M-theory. Loop quantum gravity proponents have the aim of constructing a theory of quantum gravity, excluding electromagnetism and the nuclear forces. The approach treats the universe’s geometry as a network, replacing Einstein’s smooth spacetime fabric with nodes and links to which quantum properties are assigned[14]. In this way, space is built up of discrete chunks that can be interrogated by LQG.

Meanwhile, string/M-theory proposes that everything is made of infinitesimally small strings that can vibrate, stretch, join or split. In theory, contorting these strings in different ways explains all observable phenomena in the universe[13]. String/M-theory’s aims are more ambitious than LQG’s, predicting the aforementioned supersymmetric particles and additional dimensions, and the eventual unification of all of the fundamental forces of nature on a theoretical level, making it a potential Theory of Everything.

While both of these approaches are compelling, they each suffer from technical complexity. More worryingly, they both lack experimental evidence for their veracity, with little prospect for either making testable predictions. This means that neither LQG nor string/M-theory have so far managed to solve the puzzle of how to combine general relativity and quantum mechanics, much less offered hope that a Theory of Everything is around the corner.

During their 2019 panel discussion on “The Dark Side of the Universe”, David Gross and George Smoot diverged from the main topic to have a conversation about quantum gravity theories in the context of cosmology. Gross was optimistic that cosmology, particularly observations from the earliest moments after the Big Bang, could provide particle physicists with data to test theories of quantum gravity, such as string theory. In contrast, Smoot gave the counterargument that a quantum theory of gravity may never be needed, at least in a cosmological context.

(00:39:00 - 00:44:36)

The complete video is available here.

Lindau Perspectives

Efforts, both theoretical and experimental, to go beyond the Standard Model now span decades, and progress has been slow. In the light of this situation, it is reasonable to ask if we will ever “know the mind of God” and develop a Theory of Everything. This question has no doubt occupied the minds of many Lindau visitors. But given the speculative nature of the topic, few have ventured to lecture on it.

Brian Josephson (Nobel Prize in Physics 1973) and David Gross are two exceptions, with very different viewpoints. In his 2012 talk, Josephson took a highly non-conventional approach to theories beyond the Standard Model, asking whether we should ground physics in mathematics or something else. He argued that a disconnect between mathematics and physics has emerged as physicists have tried to solve quantum gravity, and argued for a biological phase of reality in which observer-participancy is key.

(00:00:52 - 00:03:06)

The complete video is available here.

On the other hand, in his 2019 lecture, Gross not only briefly outlined string theory and why it offers hope of unifying all four fundamental forces, but he also explained the extreme difficulty in experimentally confirming that gravity merges with the other three forces. He concluded his talk with the question: “Is there a final theory?”, which he explained is equivalent to asking, “Is there a finite amount of ignorance?”. Though he stated that there is no sign that ignorance is finite, he also offered hope by mentioning that the language of physics – mathematics – has a certain infinite capacity, meaning there are no signs that we are faced with questions that cannot be answered.

(00:17:10 - 00:34:40)

The complete video is available here.

Bibliography

[1] Hawking, S. (1988) A Brief History of Time. Published by Bantam Books, New York

[2] Maxwell, J. C. (1865) A dynamical theory of the electromagnetic field. Philosophical Transactions of the Royal Society of London. Vol. 155, 459–512

[3] http://www.clerkmaxwellfoundation.org/html/about_maxwell.html

[4] Nobel Prize in Physics 2017: Summary

[5] Lee, T. D (1987) History of the weak interactions. CERN Courier. January/February, 7¬–12

[6] Nobel Prize in Physics 1949: Facts

[7] Dirac, P. A. M. (1927) The quantum theory of the emission and absorption of radiation. Proceedings of the Royal Society of London A. Vol. 114, 243–265

[8] Nobel Prize in Physics 1965: Summary

[9] Nobel Prize in Physics 1979: Summary

[10] Nobel Prize in Physics 1999: Summary

[11] Leutwyler, H. (2012) On the history of the strong interaction arXiv:1211.6777

[12] Nobel Prize in Physics 2004: Summary

[13] Greene, B. (2000) The Elegant Universe. Superstrings, Hidden Dimensions, and the Quest for the Ultimate Theory. Published by Random House, London.

[14] https://www.edge.org/conversation/lee_smolin-loop-quantum-gravity-lee-smolin