Subatomic Particles

by Anders Bárány

Nobel Prizes and Subatomic Particles

Since the first Nobel Prize in Physics was awarded to Röntgen in 1901, about 50 scientists have received the prize for inventions or discoveries connected to the physics of subatomic particles (not including nuclear physics). This means that about 25% of all the Nobel Prizes in Physics have been given to work done in this field. In 1906, the first one rewarded J.J. Thomson “in recognition of the great merits of his theoretical and experimental investigations on the conduction of electricity by gases” or in short “for his discovery of the electron”, made in 1897. The second discovery of a subatomic particle rewarded by a Nobel Prize is usually attributed to A.H. Compton, who received one of the 1927 prizes “for his discovery of the effect named after him” or, in other words, “for the discovery of the photon”, made in 1923. The next is J. Chadwick, who discovered the neutron in 1932 and received the Nobel Prize in Physics for this in 1935. Electron, photon and neutron, but what about the proton? Well, when Rutherford discovered the atomic nucleus in 1911 and identified the proton in 1919, he had already received a Nobel Prize in Chemistry 1908. So it was argued that he didn’t need another Nobel Prize, with the result that the discovery of the proton went unrewarded!

With all the particles relevant to the chemistry of atoms and molecules discovered, we now turn to some of the more exotic subatomic particles made of antimatter. The antielectron, which received the name positron, arrived in 1932 and C.D. Anderson was awarded one of the 1936 Nobel Prizes in Physics for the discovery. In 1955 an accelerator specifically constructed for the purpose produced the antiproton, for the discovery of which E.G. Segrè and O. Chamberlain received the Nobel Prize in Physics 1959. The discovery of the antineutron was made in the same accelerator by the same scientists, and as for Rutherford’s discovery, this one went unrewarded.

Cosmic radiation was discovered by V.F. Hess in the 1920’s and he received the Nobel Prize in Physics for this in 1936, sharing the reward money with Anderson, who had used cosmic radiation to discover the positron. The main instrument used to study cosmic radiation at this time was the cloud chamber, an invention by meteorologist C.T.R. Wilson. He received one of the 1927 Nobel Prizes in Physics and shared the prize money with Compton, who had used the cloud chamber to discover the photon. P.M.S. Blackett developed a technique to automatically take photos of the tracks in the cloud chamber and managed to take the first photo of a nuclear reaction. For this he was rewarded with the 1948 Nobel Prize in Physics “for his development of the Wilson cloud chamber method, and his discoveries therewith in the fields of nuclear physics and cosmic radiation”. With increasing interest, a new photographic technique was developed, which did not rely on the cloud chamber. Instead the tracks of the particles were registered in a photographic emulsion. C.F. Powell was rewarded with the 1950 Nobel Prize in Physics “for his development of the photographic method of studying nuclear processes and his discoveries regarding mesons made with this method”.

So what is a meson? Theoretician H. Yukawa suggested in the 1930’s that the strong nuclear force keeping the atomic nucleus together was communicated by a particle he called meson. Yukawa proposed that the meson could be found in the cosmic radiation and in 1937, a team with Anderson, using cloud chamber techniques, discovered a new particle which they proposed was Yukawa’s meson. But when Powell studied the cosmic radiation in the late 1940’s, he found several kinds of Yukawa mesons that behaved differently from those of Anderson et al. What was discovered in 1937 was actually a kind of heavier electron, named the myon (the discovery of which has not been rewarded with a Nobel Prize). Electrons and myons are examples of a kind of particles called leptons, that are not acted upon by the strong force. In 1949 Yukawa received the Nobel Prize in Physics “for his prediction of the existence of mesons on the basis of theoretical work on nuclear forces”. But again, what is a meson? It would take 15 years before this was made clear in 1964 by M. Gell-Mann’s group theoretical quark model, which used three quarks called up, down and strange and their antiparticles. In terms of quarks, Yukawa’s mesons are made up of two of the first quarks, while protons and antiprotons have three of these. The strange quark appeared in a composite particle named omegaminus, the existence of which Gell-Mann proposed. After the actual discovery of the omegaminus, Gell-Mann received the 1969 Nobel Prize in Physics “for his contributions and discoveries concerning the classification of elementary particles and their interactions”.

So what is a meson? Theoretician H. Yukawa suggested in the 1930’s that the strong nuclear force keeping the atomic nucleus together was communicated by a particle he called meson. Yukawa proposed that the meson could be found in the cosmic radiation and in 1937, a team with Anderson, using cloud chamber techniques, discovered a new particle which they proposed was Yukawa’s meson. But when Powell studied the cosmic radiation in the late 1940’s, he found several kinds of Yukawa mesons that behaved differently from those of Anderson et al. What was discovered in 1937 was actually a kind of heavier electron, named the muon (the discovery of which has not been rewarded with a Nobel Prize). Electrons and muons are examples of a kind of particles called leptons, that are not acted upon by the strong force. In 1949 Yukawa received the Nobel Prize in Physics “for his prediction of the existence of mesons on the basis of theoretical work on nuclear forces”. But again, what is a meson? It would take 15 years before this was made clear in 1964 by M. Gell-Mann’s group theoretical quark model, which used three quarks called up, down and strange and their antiparticles. In terms of quarks, Yukawa’s mesons are made up of two of the first quarks, while protons and antiprotons have three of these. The strange quark appeared in a composite particle named omegaminus, the existence of which Gell-Mann proposed. After the actual discovery of the omegaminus, Gell-Mann received the 1969 Nobel Prize in Physics “for his contributions and discoveries concerning the classification of elementary particles and their interactions”.

Even before WWII, accelerators had started to play a role in producing subatomic particles. The first Nobel Prize in Physics which can be said to have been given for accelerator technology went to E.O.Lawrence in 1939 for his invention of the cyclotron. In 1951, J.D. Cockcroft and E.T.S. Walton were rewarded with the Nobel Prize in Physics for constructing a high tension proton accelerator. Since the discoveries of the antiproton and antineutron were made with an accelerator constructed just for this purpose, the Nobel Prize to Segrè and Chamberlain can also be seen as reward for accelerator technology. With the help of these high energy accelerators, a whole zoo of subatomic particles was discovered, the family structure of which is today embedded in the so-called Standard Model. The development of the Standard Model, with has three families of quarks and leptons, has been a major task for both theoreticians and experimentalists. Among the important inventions and developments used to produce and detect the new particles are the bubble chamber (Nobel Prize in Physics to D. Glaser 1960) and its development using data analysis (Nobel Prize in Physics to L.W. Alvarez 1968), stochastic cooling of ion beams (Nobel Prize in Physics to S. van der Meer 1984) and the multiwire proportional counter (Nobel Prize in Physics to G. Charpak 1992).

With the new technology a number of important discoveries were made, each a step towards the Standard Model. In 1969 (the year when Gell-Mann received his Nobel Prize), J.I. Friedman, H.W. Kendall and R.E. Taylor confirmed the quark structure of protons and neutrons. After 20 years they received a shared Nobel Prize in Physics 1990 “for their pioneering investigations concerning deep inelastic scattering of electrons on protons and bound neutrons, which have been of essential importance for the development of the quark model in particle physics”. These investigations were the logical continuation of those of R. Hofstadter, who received a Nobel Prize in Physics 1961 “for his pioneering studies of electron scattering in atomic nuclei and for his thereby achieved discoveries concerning the structure of the nucleons”. In 1974, B. Richter and S.C.C. Ting (shared Nobel Prize in Physics 1976) independently discovered a particle containing a heavy quark which was given the name charm. This was an important step towards the formulation and confirmation of the three-family structure of the quarks (up, down), (strange, charm), (top, bottom) and their antiparticles. The quarks of the third family were discovered in 1977 (bottom) and 1995 (top), but these discoveries have not yet led to any Nobel Prize in Physics. In 1975, M. Perl discovered a lepton even heavier than the muon. It was given the name tau, but it was not until 1995, 20 years later, that Perl finally received the Nobel Prize in Physics for the discovery. In 1979, the communicator of the strong interaction, the gluon, was discovered, a discovery which so far has not resulted in a Nobel Prize.

When during the 1920’s, detailed studies of the electrons emitted in radioactive decay showed that some energy was missing, W. Pauli suggested the existence of the neutrino. According to the suggestion, this particle would be difficult to detect since one of its properties was that its interaction with matter should be weak. It was not detected experimentally until 1956 and then only close to the large flux generated by a nuclear reactor. For this work F. Reines received the Nobel Prize in Physics, but not until 1995 (Pauli had already 1945 received a Nobel Prize in Physics, but not for his neutrino hypothesis). In 1962, L.M. Lederman, M. Schwartz and J. Steinberger used a large accelerator to produce beams of neutrinos and discovered a second type of neutrino. It turned out that one can classify the two kinds of neutrinos as related to the other two kinds of leptons, the electron and the muon. So Pauli’s neutrino was an electron neutrino and the one from 1962 was the muon neutrino. For this discovery, Lederman, Schwartz and Steinberger received the Nobel Prize in Physics, but not until 1988. After Perl’s discovery of the tau lepton in 1974, the third kind of heavy electron (see above), it was realized that there should also be a third kind of neutrino, the tau neutrino. This was finally detected in year 2000, but has not resulted in a Nobel Prize in Physics yet. This discovery closed the set of the leptons of the Standard Model: the electron and its neutrino, the muon and its neutrino, the tau and its neutrino, and their antiparticles.

A large number of theoretical inventions and discoveries are related to the development described above. In 1965, S. Tomonaga, J. Schwinger and R.P. Feynman shared the Nobel Prize in Physics “for their fundamental work in quantum electrodynamics, with deep-ploughing consequences for the physics of elementary particles”. Their theory was a unification of electromagnetism and relativistic quantum mechanics and made it possible to calculate and understand many of the important properties of the subatomic particles. In 1979, S.L. Glashow, A. Salam and S. Weinberg shared the Nobel Prize in Physics for the unification of electromagnetism and the weak interaction. This theory predicted the existence of new particles, named W and Z, which communicate the weak interaction. They were discovered by C. Rubbia and his collaborators at CERN in 1983, leading to a shared Nobel Prize in Physics for Rubbia and the accelerator physicist van der Meer already in 1984, the year after the discovery. But the theory had problems, both from a calculational and a fundamental viewpoint. These problems were solved by M.J.G. Veltman and his student G. ‘t Hooft, which eventually led to their sharing the Nobel Prize in Physics of 1999. Attempts to formulate a consistent theory of the strong interaction met problems that were solved by D.J. Gross, his student F. Wilczek, and H.D. Politzer, all three eventually sharing the 2004 Nobel Prize in Physics. The idea that there should be three families of quarks and leptons originally was formulated by M. Kobayashi and T. Maskawa, who received a shared Nobel Prize in Physics 2008.

Historic Lindau Lectures (1951-2003) and Subatomic Particles

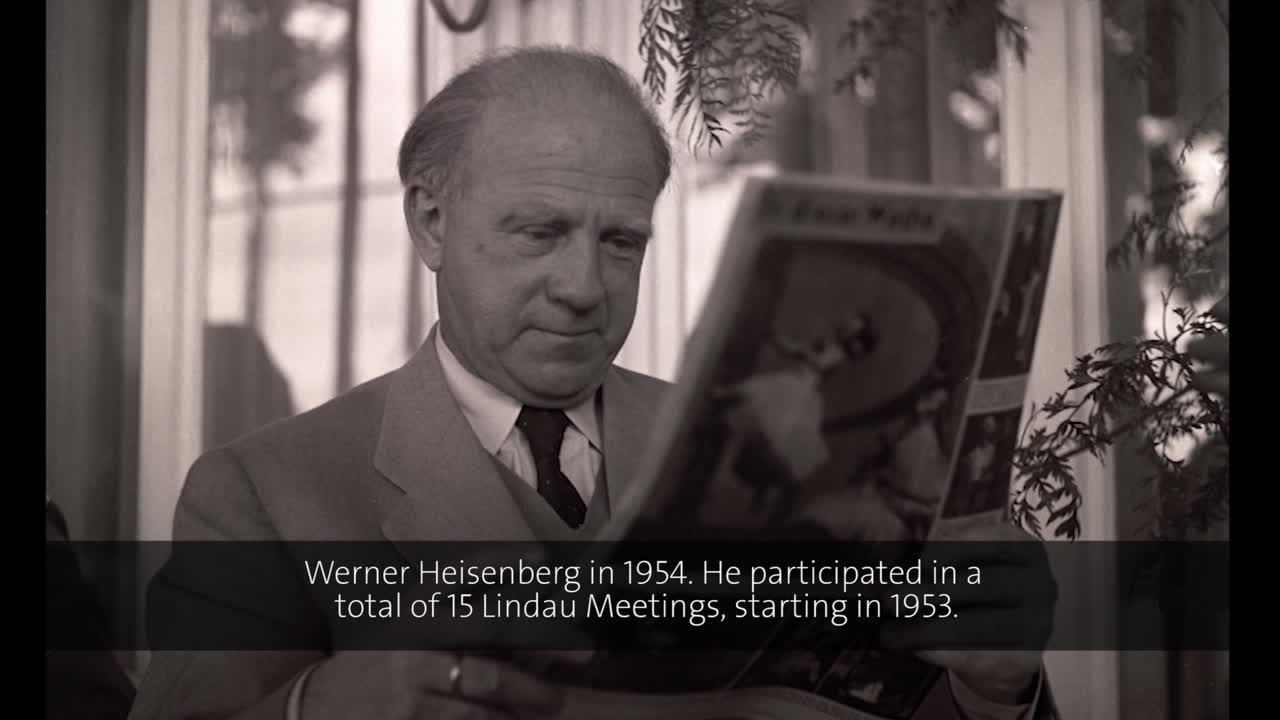

As can be seen from the description above, the physics of subatomic particles can be divided into two parts. The first one took place before 1950 and includes the discoveries of the basic set of particles, while the second part started roughly the same year as the Lindau Meetings, in 1951. So there is no surprise in finding that there is a long list of lectures with topics that can be classified as belonging to subatomic physics. Already at the first physics meeting, in 1953, both Werner Heisenberg and Hideki Yukawa lectured on attempts to find a unified theory of elementary particles, a topic which has followed the Lindau Meetings well into the 21st Century.

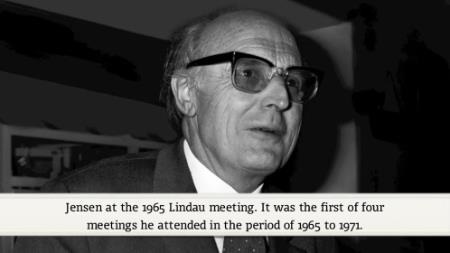

But some Nobel Laureates choose not to talk so much about their own research and the research frontier, but rather about the history of subatomic physics and accelerators. Hans Jensen, who received a Nobel Prize in Physics 1963 together with Maria Goeppert-Mayer “for their discoveries concerning nuclear shell structure”, gave only one lecture in Lindau. This was at the 1965 meeting and its title (translated into English) was “The change of meaning of the term elementary particle”. In a comprehensive and rather non-technical way, Jensen gives an introduction to the elementary particles known in 1965. He starts with the ancient Greeks, spends some time quoting Isaac Newton and continues all the way up to around 1965. Although he doesn’t report any results of his own, at the end he gives an interesting and rather detailed discussion of the problems posed by the zoo of new “elementary” particles found after 1950. He does mention the name of Gell-Mann, but the solution of the problems, the idea of quarks, is not mentioned.

(00:20:06 - 00:22:46)

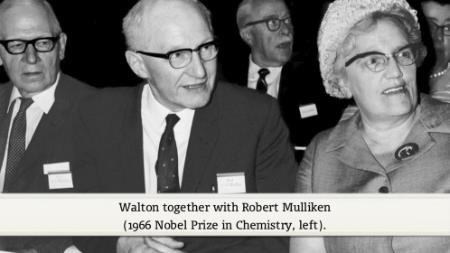

As mentioned above, the history of subatomic particles is closely connected with the development of accelerators. Ernest Walton received the 1951 Nobel Prize in Physics jointly with John Cockcroft “for their pioneer work on the transmutation of atomic nuclei by artificially accelerated atomic particles”. In 1968, Walton gave his only lecture at Lindau, with the title “Particle accelerators with special reference to their early history”. Being a specialist in accelerator technology, Walton gives a clear and engaging story of his work in Cambridge under the mentorship of Ernest Rutherford. The high point of his story, of course, is the construction of a high-tension accelerator together with Cockcroft. The instrument was used to make protons enter atomic nuclei by the tunnel effect.

(00:13:06 - 00:15:25)

The first accelerators were small enough for a university or research institute to construct and effectively use them. But quite soon the need of larger machines was felt and in Europe discussions about a joint laboratory started. When the theoretical physicist Werner Heisenberg, who received the 1932 Nobel Prize in Physics “for the creation of quantum mechanics…”, gave his first lecture at the Lindau Meetings in 1953, he mentioned that a few days before the lecture, an agreement to build such a laboratory in Geneva had been signed in Paris. Today we all know that this laboratory became CERN, which, with its Large Hadron Collider (LHC), is the world leading laboratory for subatomic physics. Over the years, a whole series of larger and larger accelerators were constructed at CERN. In 1971, Heisenberg’s lecture bears the title “Physical and political aspects of the construction of large particle accelerators”. In the unusual and interesting lecture, Heisenberg discusses the pros and cons of the construction of a new accelerator at CERN. A main pro argument is that history tells us that every increase in particle energy has brought new interesting results. On the con side, an argument is that we already have higher energies through the existence of cosmic radiation. But finally and importantly, Heisenberg also argues for CERN as an ideal case for European integration!

(00:26:21 - 00:28:58)

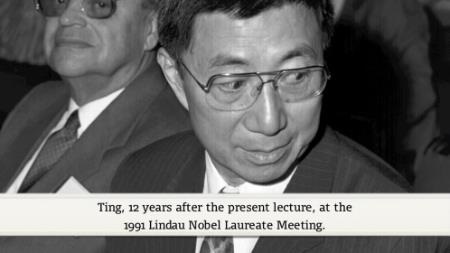

With the advent of high energy accelerators, a new kind of collaboration in physics evolved. Extensive international collaborations are needed to scrape together funding and manpower for the construction of detectors, for performing experiments and for analysing large sets of data. Such collaborations are usually led by well known physicists with a knack for organization. They are often travelling physicists, who go around the world looking for opportunities at the large machines. Samuel Ting, who was born in the US but raised in China, received the Nobel Prize in Physics 1976 together with Burton Richter “for their pioneering work in the discovery of a heavy elementary particle of a new kind”. Ting’s discovery was made at the Brookhaven National Laboratory (BNL) in the US, but in his first talk in Lindau, entitled “Light Rays, Massive Light Rays, and New Particles in Nature”, he starts by describing his work at the German laboratory DESY in Hamburg. Then he moves over to BNL and then back to Germany again, when a new accelerator is opened up at DESY. This talk, given in 1979, brings forward the problems and breakthroughs of an active experimental physicist in a wonderful way!

(00:44:56 - 00:47:16)

Rudolf Mößbauer, who passed away in 2011, received a Nobel Prize in Physics 1961 at age 32 “for his researches concerning the resonance absorption of gamma radiation and his discovery in this connection of the effect which bears his name”. As some other Nobel Laureates, Mößbauer eventually changed his interest from the prize-awarded area to something quite different. In 1982, when he lectured in Lindau for the 6th time, the title of his lecture was “The world is full of neutrinos”. This interest of his had begun when he acted as director of the French-German(-British) research reactor ILL in Grenoble, a reactor which had been constructed to give a high flux of neutrons, but which also gave a high flux of neutrinos. Mößbauer goes through the history of neutrinos, from Wolfgang Pauli’s idea to Frederick Reines’ detection of reactor neutrinos to Raymond Davis’ first observation of solar neutrinos. Since neutrinos are so unwilling to interact with matter, they are hard to detect and their properties are difficult to observe. Two particular questions are on Mößbauer’s mind: the mass of the neutrinos and the possibility for neutrinos to oscillate from one type to another. Today, both these questions have found their answers (the mass is non-zero, they do oscillate). These answers could only be found by the construction of very large and expensive underground detectors.

(00:19:42 - 00:22:55)

The theoretical physicist Steven Weinberg received the Nobel Prize in Physics 1979 together with Abdus Salam and Sheldon Glashow “for their contributions to the theory of the unified weak and electromagnetic interaction between elementary particles, including, inter alia, the prediction of the weak neutral current”. One might think that a lecture given by such a Nobel Laureate might be very difficult to understand. But Weinberg is gifted with a talent for popularisation, as can be judged from his well-known book “The first three minutes”. In his lecture in Lindau 1982, entitled “Prospects for Further Unification in the Theory of Elementary Particles”, he first gives a very clear presentation of the Standard Model. He then leads the discussion into questions of the unknown by introducing supersymmetry, a property which is still under discussion and which is actively looked for at the LHC at CERN today (02/2012).

Theoretical physicists thrive on ideas that can be treated mathematically, but always have to wait for experiments to decide if their ideas survive as theories. David Gross, who received the Nobel Prize in Physics 2004 together with David Politzer and Frank Wilczek “for the discovery of asymptotic freedom in the theory of the strong interaction”, has been an active proponent for string theories and other mathematically intriguing extensions of the known theories of subatomic particles. When he gave his Lindau lecture in 2008, he felt the day coming when some of his theories would be put to test by the LHC at CERN and gave his talk the title “The Large Hadron Collider and the Super World”. Today, (02/2012), the accelerator experiments have not been able to answer his questions. But since both the energy of the particles in the LHC and the statistics of detection are increasing functions of time, some answers might still be out there!

Additional lectures by the Nobel Laureates associated with Subatomic Particles:

Introductory Mini Lecture on Subatomic Particles

Werner Heisenberg 1953: Developments and Difficulties in the Quantum Theory of Elementary Particles

Hideki Yukawa 1953: Attempt at a Unified Theory of Elementary Particles.

Paul Dirac 1956: Electrons and the Vacuum.

Werner Heisenberg 1956: Problems in the Theory of Elementary Particles (German presentation).

Hideki Yukawa 1956: Elementary Particles.

Werner Heisenberg 1959: Report on Recent Findings Regarding A Unified Field Theory of Elementary Particles.

Werner Heisenberg 1962: Progress in the Unified Field Theory of Elementary Particles (German presentation.

Robert Hofstadter 1962: Recent Results on Nucleon Structure.

George Thomson 1965: Discovery of the Electron.

Robert Hofstadter 1968: New Detectors for High Energy Physics.

Robert Hofstadter 1971: Detectors for High Energy Physics.

Robert Hofstadter 1973: Applications to High Energy Physics of New Total Absorption Detectors.

Chen Ning Yang 1973: The Structure of the Proton.

Robert Hofstatder 1982: The Crystal Ball Experiment.

Val Fitch 1982: Aspects of CP-Violation.

Samuel Ting 1982: Quarks, Gluons and New Particles in Nature.

Il'ja Frank 1985: Some Peculiarities of Neutron-Nuclear Interaction.

Rudolf Mössbauer 1985: The Rest Masses of the Neutrinos.

Samuel Ting 1985: Search for the Fundamental Building Blocks of Nature.

Simon van der Meer 1988: Plans for Future Electron Positron Colliders.

Rudolf Mössbauer 1988: The Solar Neutrino Problem.

Frank Wilczek 2005: The Universe is a Strange Place.

Martinus Veltman 2008: The Development of Particle Physics.

David Gross 2010: Frontiers of Physics.

Gerardus ’t Hooft 2010: The Big Challenges.