DNA, Genes and Genetic Engineering

by Neysan Donnelly

In 1866, a German-speaking monk named Gregor Johann Mendel from today’s Czech Republic publishes a scientific treatise concerning the inheritance of traits in peas…

…five years later, a Swiss researcher called Friedrich Miescher isolates a mysterious phosphate-rich substance from the nuclei of white blood cells, which he christens “nuclein”.

These two discoveries did not appear to be connected to each other; in any case, neither work made great waves at the time. However, Mendel and Miescher paved the way for the discovery and characterisation of DNA, and allowed researchers to determine that DNA contains genes, the individual units that encode the different functions required for life and that mediate the transmission of traits across generations.

After Miescher’s isolation of the curious substance, other researchers then took up the baton and got to grips with characterising its chemical structure. Albrecht Kossel, a biochemist from Rostock in Germany determined that “nuclein” was composed of both protein and non-protein portions. His crowning achievement, for which he received the Nobel Prize in Physiology or Medicine in 1910, was the eventual isolation of the five so-called nucleobases from the non-protein portion: adenine, cytosine, guanine, thymine and uracil. The next major milestone was the elucidation of the chemical structure of these building blocks of DNA. The Nobel Prize in Chemistry in 1957 was awarded to Alexander Todd in recognition of synthesis and degradation studies that led to the realisation that nucleotides were composed of sugar, base and phosphate portions.

By 1900, Mendel’s principles had been independently verified and then rediscovered by at least four other scientists, and approximately 10 years previously the Dutch botanist Hugo de Vries proposed that the inheritance of traits might be mediated by discrete elements or particles, termed “pangenes”. Where were these mysterious “pangenes”?

The structures that we now know as chromosomes were independently observed by several German and Swiss scientists from the mid-1800s onwards. However, it wasn’t until the turn of the century that two researchers, the American Walter Sutton and the German Theodor Boveri, pointed to chromosomes as the carriers of genetic material, the so-called chromosome theory of inheritance. Subsequent work by two Americans: Eleanor Carothers and, most famously, Thomas Morgan provided strong support for this theory. Carothers was the first to observe that chromosomes are independently sorted during meiosis, while Morgan, in experiments with fruit flies, showed that certain traits were encoded on sex chromosomes and that it was likely that other traits were also carried on other individual chromosomes. Morgan received the Nobel Prize in Physiology or Medicine in 1933 for his discoveries. Modern genetics was born.

However, an understanding of the actual composition of the genetic material was still lacking. For many years, in fact, it had been thought that protein mediated the transmission of traits and characteristics. This idea persisted until the seminal experiments of the American Oswald Avery in 1944. Avery succeeded in transferring disease-causing ability between bacterial strains and in proving that it was the nucleic acid that was transmitting this ability. This showed that genes are composed of nucleic acid. At around the same time that these findings of Avery were published, further impetus came from a perhaps unlikely source: Erwin Schrödinger, Nobel Laureate in Physics 1933. In a series of lectures given in Ireland in 1943, the Austrian physicist expounded ideas that would have a massive influence on a generation of physicists and biologists. Schrödinger argued that genetic material must contain a “code-script” that determines an individual’s development.

Inspired by the findings of Avery to study DNA, an Austro-Hungarian scientist named Erwin Chargaff formulated a law with profound implications. He was able to show that, under natural conditions, the number of guanine nucleobases is equal to the number of cytosines, and that the number of adenines is equal to the number of thymine nucleobases. This strongly suggested that these four bases were pairing with each other in DNA molecules, i.e., guanine with cytosine, and adenine with thymine. The stage was now set for perhaps the most spectacular discovery in the history of research into DNA: determination of its molecular structure and the realisation that the sequence of bases was responsible for determining the traits observed by Mendel, Sutton, Boveri and others, and was the “code-script” spoken of by Schrödinger.

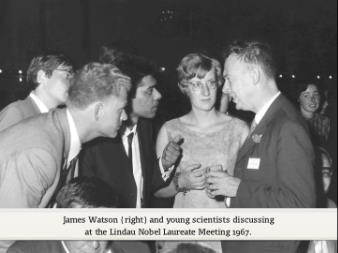

The discovery of the structure of DNA by the American James Watson, the British scientist Francis Crick and the New Zealand-born Maurice Wilkins was undoubtedly inspired by this earlier work. However, it also received much more direct help: from the British crystallographer Rosalind Franklin. She had concluded that the phosphate molecules in DNA were located on the outer surface of the DNA molecule, and also made estimates of the amount of water that was to be found in it. Further, her famous “Photograph 51”, an X-ray image of DNA showing a fuzzy x-shaped structure was the last hint that Watson and Crick needed to make their breakthrough. They proposed a model in which DNA was a double helix of two anti-parallel strands with the phosphate on the outside and the bases pairing with each other on the inside. As well as paving the way for the unlocking of the code of DNA and genes, Watson, Crick and Wilkin’s findings also had deep implications for how DNA is replicated, which were immediately recognised by the scientists themselves. James Watson discussed these implications in relation to the replication of viruses at his 1967 lecture at the Lindau Nobel Laureate Meeting:

(00:13:38 - 00:16:00)

But how are large molecules of DNA put together from their nucleotide building-blocks? Shortly after the seismic findings of Watson, Crick and Wilkins, two men, Severo Ochoa and Arthur Kornberg, discovered the enzymatic process in which DNA is synthesised from nucleotides. They shared the Nobel Prize in Physiology or Medicine in 1959.

A student of Thomas Morgan, George Beadle, and Edward Tatum were responsible for another great leap forward: using X-rays to mutate the DNA of the bread mould Neurospora crassa led them to propose the famous “one gene-one enzyme hypothesis”, i.e., that each gene encodes one enzyme involved in biochemical reactions inside the cell. Although we now know the hypothesis is an oversimplification, Beadle and Tatum’s work has been hugely influential, and can be said to have ushered in the age of molecular biology and molecular genetics. In 1958, one year after Todd was honoured for his discovery of the chemical make-up of nucleotides, Beadle and Tatum shared one half of the Nobel Prize in Physiology or Medicine for their ground-breaking work.

Three other researchers added critical detail to this picture, and elucidated the key principles of how our genetic code determines protein synthesis. The experiments of Har Gobind Khorana and Marshall Nirenberg revealed the triplet genetic code that is contained in DNA, and then transcribed into RNA and which encodes amino acids, the building blocks of proteins. In complementary work, Robert Holley characterised the structure of a transfer RNA, the adaptor molecules that assemble proteins by reading the messenger RNA code. The three researchers shared the 1968 Nobel Prize in Physiology or Medicine.

The way in which the DNA molecule is organised and replicated leads to an inherent problem: DNA duplication cannot proceed all the way until the end of the molecule, and thus the chromosome shortens with each round of replication. How do cells counteract this detrimental phenomenon?

In 2009, Elizabeth Blackburn, Carol Greider and Jack Szostak were jointly awarded the Nobel Prize in Physiology or Medicine for their discoveries related to "how chromosomes are protected by telomeres and the enzyme telomerase". Thanks to their findings and those of others we now know what telomerase is composed of and have an understanding of the exquisitely complex maintenance of telomeres, the structures that protect the ends of our chromosomes from erosion:

(00:08:14 - 00:09:07)

In this excerpt from her talk at the Lindau Nobel Laureate Meeting in 2011, Blackburn discusses the challenges associated with understanding telomeres, how the technology developed by double Nobel Laureate Frederick Sanger and Walter Gilbert aided her initial investigations and the strategies that she then pursued to understand these critical structures:

(00:08:09 - 00:10:26)

Damage to our DNA and how our cells repair it

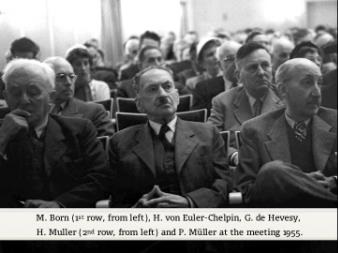

The realisation that X-rays and other forms of radiation can cause detrimental mutations was due, in large part, to the findings of the American geneticist Hermann Joseph Muller. In 1946, Muller was awarded the Nobel Prize in Physiology or Medicine for his important discovery. He devoted much of his later career to warning about the harmful effects of radiation, especially of the medical kind, on human health, like in this excerpt from his 1955 talk at the 5th Lindau Nobel Laureate Meeting:

(00:46:40 - 00:47:47)

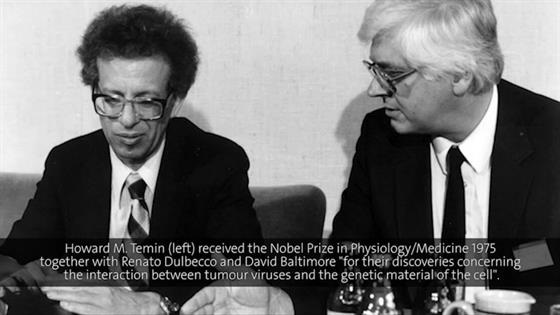

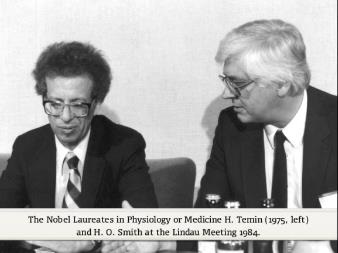

Radiation is not the only agent that engages in harmful interactions with our DNA. Viruses, small infectious particles that live and reproduce only after infecting host cells, also alter our genetic material, with potentially fatal consequences. In pioneering experiments performed as early as 1911, Peyton Rous had discovered that cancer could be transmitted by a virus. He finally received the Nobel Prize in Physiology or Medicine in 1966. In 1975, David Baltimore, Renato Dulbecco and Howard Temin were jointly awarded the Nobel Prize in Physiology or Medicine "for their discoveries concerning the interaction between tumour viruses and the genetic material of the cell". In essence, Baltimore, Dulbecco and Temin discovered that viruses can insert themselves into our DNA and in this way cause cancer. How do they do this? In this extract from his 1984 talk at the 34th Lindau Nobel Laureate Meeting entitled “How Some Viruses Cause Cancer”, Howard Temin explains how retroviruses, which are actually composed of RNA, integrate their genetic material into our DNA genomes:

(00:03:40 - 00:06:53)

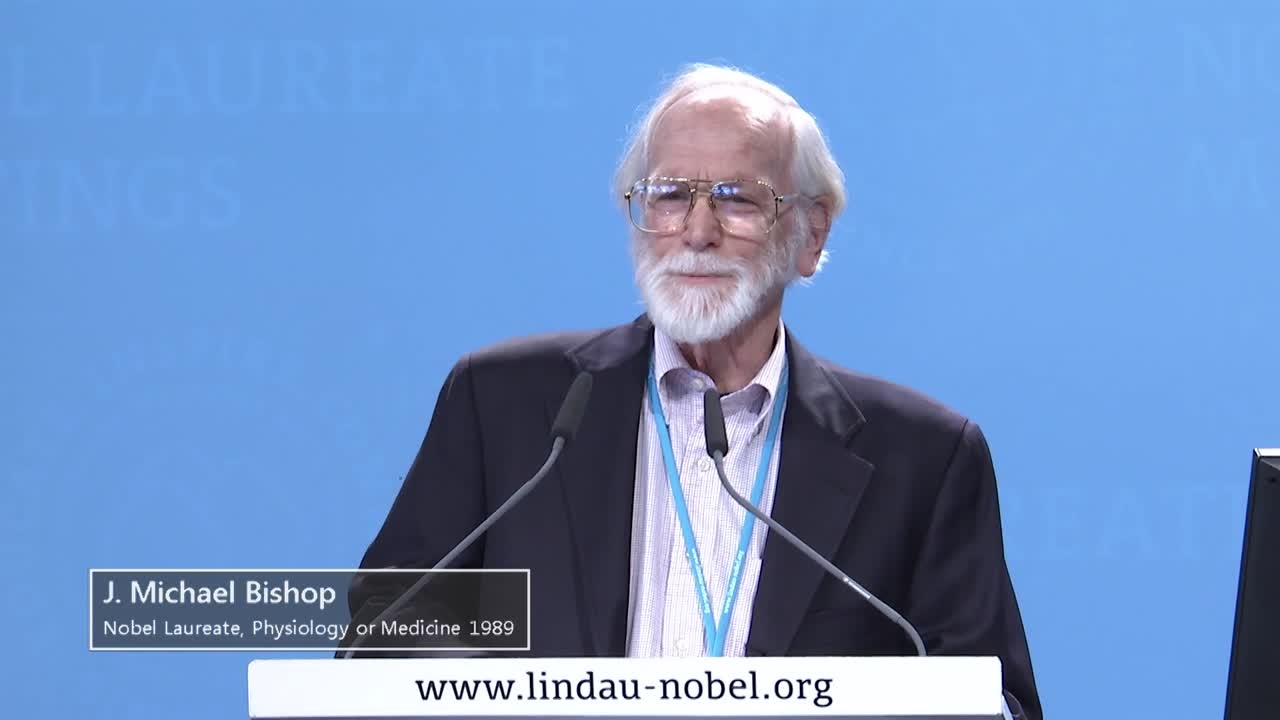

One important way in which such viruses can then go on to cause cancer is through proto-oncogenes, genes that the viruses can steal from our genomes and incorporate into their own ones. Such genes are then mutated or expressed inappropriately and drive abnormal growth. These findings were not only significant because they show how rogue microscopic agents can cause malignant transformation; they also led to the realisation that the seed of cancer lies in our own genes and DNA. For their work in studying retroviral oncogenes, J. Michael Bishop and Harold Varmus were awarded the 1989 Nobel Prize in Physiology or Medicine. In this lecture from 2015, Bishop briefly describes the discovery of the first oncogene, src:

(00:19:51 - 00:22:10)

Towards the close of his lecture he describes how the discovery and characterisation of retroviral oncogenes led to an appreciation of the wider role of proto-oncogenes in cancer:

(00:28:58 - 00:30:36)

The Nobel Prize in Chemistry in 2015 was jointly awarded to Thomas Lindahl, Paul Modrich and Aziz Sancar for their characterisation of three of the most important repair mechanisms that safeguard the integrity of our genetic information. While X-ray radiation and viruses are important sources of damage to our genetic material, much DNA damage also occurs “naturally” or spontaneously, i.e., during normal processes of metabolism. In this excerpt from his lecture at the 67th Lindau Meeting in 2017, Lindahl stresses this point before going on to describe how cells repair some of the most common lesions to their DNA:

(00:08:57 - 00:11:29)

The importance of DNA repair was also underlined by Werner Arber in his talk at the 61st Lindau Nobel Laureate Meeting in 2011, in which he discussed repair mechanisms that correct base-pair mismatches arising during DNA replication:

(00:21:31 - 00:22:23)

How Nature Ensures the Diversity of Genetic Material

Even though radiation, viruses and many other stimuli both from outside and inside our bodies have the potential to wreak havoc on our genetic material, a certain level of “mistakes” and genetic variation can be beneficial. Bacteria, for example, are highly adept at sharing genes between themselves in a process known as gene transfer. The American molecular biologist Joshua Lederberg discovered two modes of gene transfer, conjugation and transduction. For his achievement, he shared the 1958 Nobel Prize in Physiology or Medicine with George Beadle and Edward Tatum. In his talk at the 31st Lindau Nobel Laureate Meeting in 1981, Nobel Laureate Hamilton Smith (Medicine or Physiology, 1978) talks about the three known mechanisms of gene transfer in bacteria:

(00:05:13 - 00:07:16)

Werner Arber has a particular interest in Darwinian evolution and how changes to DNA act as the raw material for natural selection. In this short excerpt from his lecture during the 57th Lindau Meeting, he discusses the different kinds of changes that can affect the DNA of microbial species:

(00:34:00 - 00:36:49)

Genetic Engineering

Scientists now possess a large kit of tools that can be used to alter DNA in beneficial ways, such as techniques that allow the transfer of genes between organisms or the replacement of defective genes with non-defective ones. In fact, thanks to CRISPR/Cas9 technology, the permanent modification of genes is easier today than it ever has been.

One fundamental technique of genetic engineering is molecular cloning, which involves the cutting out of a DNA sequence from one location and its pasting into a second one. This method has allowed a vast array of downstream applications, including the production of transgenic organisms, and gene therapy. Molecular cloning today would be unimaginable without the use of so-called restriction enzymes, proteins that cut DNA sequences at defined sites, and which evolved in bacteria as defence mechanisms against invading viruses. For their work in discovering different classes of these enzymes, Werner Arber, Daniel Nathans and Hamilton O. Smith were awarded the 1978 Nobel Prize for Physiology or Medicine. In his talk at the 59th Lindau Nobel Laureate Meeting in 2009, Werner Arber talks about the basic mechanisms of some of the different restriction enzymes:

(00:29:13 - 00:32:09)

Scientists working on the effects of viruses on our genetic material soon realised that these viruses might also be engineered to introduce other genes into host species. The American Paul Berg was the first to successfully do this with a technique involving restriction enzymes; he was awarded one half of the 1980 Nobel Prize for this achievement. In his 1981 lecture entitled “The Evolution of Retroviruses”, Howard Temin talks about the steps involved in his work on the engineering of viruses to carry foreign genes:

(00:18:06 - 00:19:52)

Gene targeting is another revolutionary approach for manipulating DNA and has enabled important insights into the role of specific genes in a wide range of diseases and critical cellular process. The technique was developed independently by Oliver Smithies and Mario Capecchi in the 1980s, and in 2007 the pair was awarded the Nobel Prize in Physiology or Medicine. In this lecture from 2015, Smithies describes how he initially developed the gene targeting technique to treat the mutation that causes sickle cell anaemia:

(00:22:04 - 00:26:02)

The polymerase chain reaction, a technique in which millions of copies of a given DNA molecule can be obtained from only one starting copy, has revolutionised molecular biology enabling many kinds of analysis and manipulation of DNA. Kary Mullis was awarded one-half of the 1993 Nobel Prize for Chemistry for inventing the method. In the same lecture from 2015, Oliver Smithies talks about how PCR also aided him in his ground-breaking work:

(00:27:24 - 00:28:58)

What of DNA technology today? Not content with revolutionising biological research once with the discovery of restriction enzymes, in 1995 Hamilton Smith led the team that sequenced the first bacterial genome, that of Haemophilus influenzae. He now works in the field of synthetic biology and tries to understand the core genetic elements that are required for life. In this excerpt from a lecture he gave at the 64th Lindau Nobel Laureate Meeting in 2014, Smith describes the concept behind his current work:

(00:14:29 - 00:15:55)

Genetic engineering and alterations to the genetic code are some of the most controversial aspects of science. The ease with which genetic information can now be permanently altered means that this issue is more topical than ever, nowhere more than in discussions related to the use of CRISPR/Cas9 technology. Like the restriction enzymes discovered by Werner Arber and Hamilton Smith, CRISPR was first discovered as a defence system in bacteria, where it functions as a form of “molecular memory” that results in the targeting of the Cas9 enzyme to foreign DNA, ensuring its destruction. Its repurposing as a potent and specific gene editing technique has led to proposals to use it to permanently alter the DNA of human embryos in order to cure, or provide resistance, to human disease. However, concerns related to safety as well as the ethical implications of permanently editing the germline mean that its use is still heavily regulated. In this lecture from 2015, Werner Arber talks about the potential risks associated with genetic engineering in general, and specifically with transferring genes between species:

(00:18:55 - 00:20:44)

One area where the potential of genetic engineering is perhaps greatest is that of crop production. World food demand is steadily rising and we require new ways of increasing crop yield. The genetic modification of food crops can help us to meet this goal, but is opposed by many. Richard Roberts shared the Nobel Prize in Physiology and Medicine in 1993 for his discovery that one and the same gene can code for different proteins. In this talk from the 65th Lindau Nobel Laureate Meeting in 2015, he explains why he believes that the genetic modification of plants is not more dangerous (and probably even safer) than traditional breeding methods:

(00:09:33 - 00:11:28)

The issues surrounding the use of genetic engineering to boost food supply highlight how fraught the debate regarding genetic modification remains. Certainly, although the scientific evidence is strong, tinkering with human genetic material or with the genetic material of our food is still simply unacceptable to many on a very visceral level. Moving forward in a productive manner will require efforts from both sides of this debate. Scientists should avoid hubris and high-handedness and should instead endeavour to communicate clearly the technology, promise, but also potential risks associated with genetic engineering, whilst also trying to understand the doubts that people may have. Opponents of genetic engineering must, meanwhile, in good faith, examine the evidence for genetic engineering, instead of simply cherry-picking data that support the beliefs that they already hold.

Some Further Reading on DNA and Genetics:

Textbooks:

Bruce Alberts, et al., “Molecular Biology of the Cell (6th ed.)” (2014) Garland Science, ISBN 978-0815344322

Jocelyn E. Krebs, et al., “Lewin's GENES XII (12th ed.)” (2017) Jones & Bartlett Learning, ISBN 978-1284104493

Popular Science/Science History:

James D. Watson, “The Annotated and Illustrated Double Helix, edited by Alexander Gann and Jan Witkowski” (2012) Simon & Schuster, ISBN 978-1-4767-1549-0

Richard Dawkins, “The Selfish Gene (30th anniversary ed.)” (2006) Oxford University Press, ISBN 978-0-19-929115-1

John Quackenbush, “The Human Genome: Book of Essential Knowledge (Curiosity Guides)” (2011) Imagine, 978-1936140152

For Younger Readers:

Cheryl Bardoe, “Gregor Mendel: The Friar Who Grew Peas” (2015) Harry N. Abrams, ISBN 978-1419718403